安装大概步骤:

1.先安装一台虚拟机,装好jdk,hadoop配置

2.复制克隆出三台,搭建ssh免密登陆

一.先准备一台虚拟机

1.防火墙:

关闭防火墙:systemctl status firewalld

防止防火墙自启:systemctl disable firewalld

2.安装JDK

3.修改主机:hostnamectl set-hostname hdp-01

vi /etc/hosts 追加

192.168.31.114 hdp-01

192.168.31.115 hdp-02

192.168.31.116 hdp-03

192.168.31.117 hdp-04

4.修改hadoop配置

4.1修改hadoop-env.sh

export JAVA_HOME=/root/jdk1.8.0_151

4.2修改core-site.xml

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://hdp-01:9000</value> </property> </configuration>

4.3修改hdfs-site.xml

<configuration> <property> <name>dfs.namenode.name.dir</name> <value>/root/hdpdata/name/</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/root/hdpdata/data</value> </property> <property> <name>dfs.namenode.secondary.http-address</name> <value>hdp-02:50090</value> </property> </configuration>

二、复制克隆出三台,搭建ssh免密登陆

1.搭建ssh免密登陆:

ssh-keygen -t dsa

2.配置环境变量

export HADOOP_HOME=/root/apps/hadoop-2.9.1

:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

3.启动hdfs

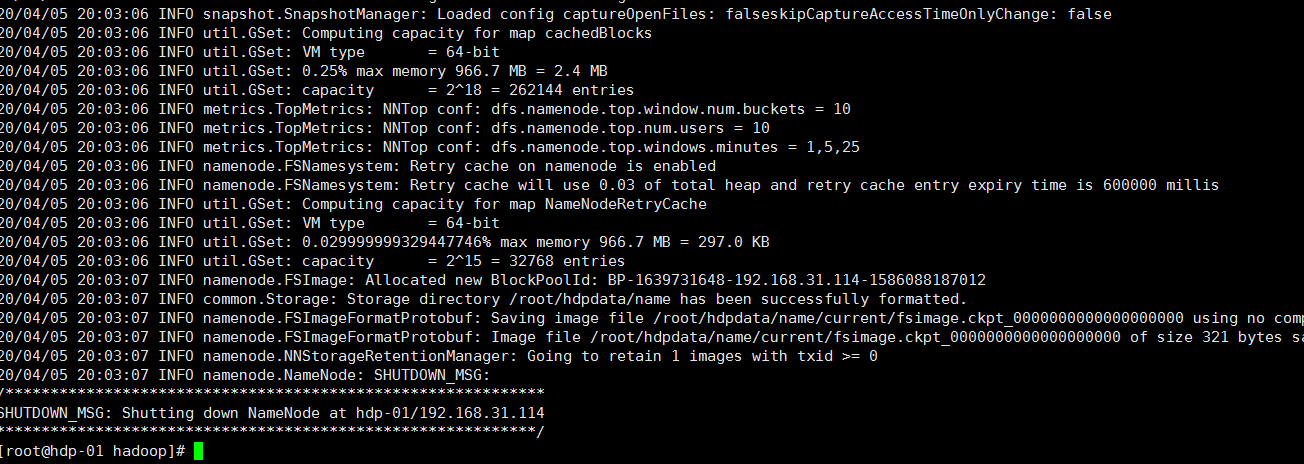

首先,初始化namenode的元数据目录

要在hdp-01上执行hadoop的一个命令来初始化namenode的元数据存储目录

hadoop namenode -format

l 创建一个全新的元数据存储目录

l 生成记录元数据的文件fsimage

l 生成集群的相关标识:如:集群id——clusterID

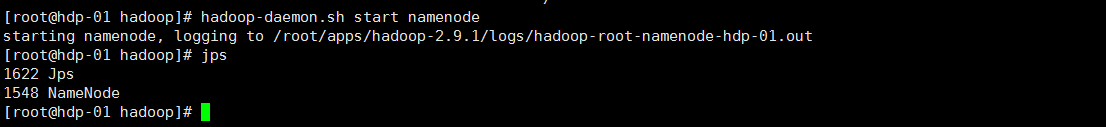

然后,启动namenode进程(在hdp-01上)

hadoop-daemon.sh start namenode

启动完后,首先用jps查看一下namenode的进程是否存在

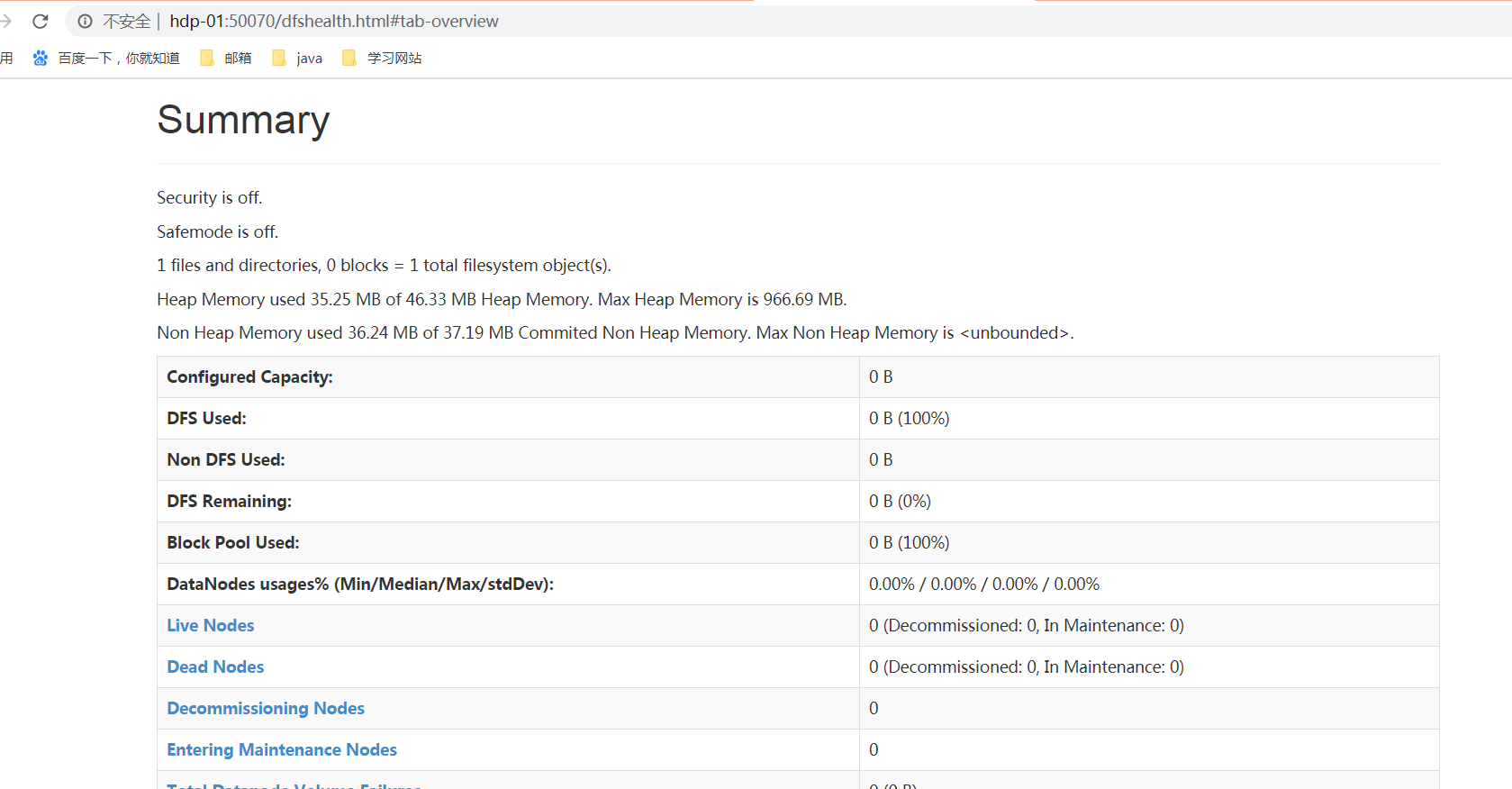

然后,在windows中用浏览器访问namenode提供的web端口:50070

http://hdp-01:50070

然后,启动众datanode们(在任意地方)

hadoop-daemon.sh start datanode

6) 用自动批量启动脚本来启动HDFS

1) 先配置hdp-01到集群中所有机器(包含自己)的免密登陆

2) 配完免密后,可以执行一次 ssh 0.0.0.0

3) 修改hadoop安装目录中/etc/hadoop/slaves(把需要启动datanode进程的节点列入)

|

hdp-01 hdp-02 hdp-03 hdp-04 |

4) 在hdp-01上用脚本:start-dfs.sh 来自动启动整个集群

5) 如果要停止,则用脚本:stop-dfs.sh

来源:https://www.cnblogs.com/mufeng07/p/12637569.html