论文:深度时空视频上采样网络

文章检索出处:2020 ECCV

代码:https://github.com/JaeYeonKang/STVUN-Pytorch

摘要

问题: 解决视频在空间和时间上的联合上采样问题的一种方法是逐个独立运行VSR和FI,效率低下。在VSR中,大多数方法都包括特征提取、对齐、融合和重构四个阶段。对于FI,该过程可分为特征提取、特征插值和重构。

贡献:1. 本文提出了一种用于时空视频上采样的端到端框架(STVUN),通过共享特征提取模块和重构模块,有效地将VSR和FI合并为一个联合框架。

2. 提出了基于时空权值的早期融合方法(EFST)来有效融合输入特征,而无需进行显示运动补偿。

3. 该框架能够在空间上上采样×4,在时间上上采样×∞。

4. 收集了STVT数据集,用于评估联合时空上采样任务。

方法

架构

网络由多个模块组成:编码器、空间上采样特征融合(EFST)、帧内插流量估计器和解码器。框架采用7个LR帧作为输入[0-7)。然后,它输出中心HR帧 Y ^ 3 \hat Y_3 Y^3以及N个HR中间帧 Y ^ T \hat Y_T Y^T,其中T∈[3,4]。

共享权重的编码器首先被用来提取每帧的特征。在空间上采样时使用EFST对编码特征进行融合,在时间上采样时使用计算出的流对编码特征进行插值。解码块由具有共享权重的解码器组成,产生用于空间和时间上采样的残差图像,这两个图像都被添加到双线性上采样图像以产生最终的输出帧。

编码器

编码器提取每帧的特征表示,由多个密集的卷积块组成。每个稠密块通过EFST连接到解码器中相应的块上。这使得解码器可以考虑输入的时间关系。编码特征用 e t i e_t^i eti表示,其中i是块索引,t是输入帧的时间索引。

具有时空权重的早期融合(EFST)

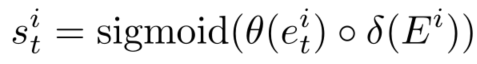

为了合并来自编码器的输入特征,我们首先应用早期融合来降低计算成本。输入的特征首先在通道维度上使用1 ×1卷积缩小7倍,得到融合结果 E i E^i Ei。因为大多数输入特征在早期融合时没有得到同等的考虑,为此,本文设计了一个置信度分数来有效地融合来自相邻帧和中心帧的信息特征。我们通过计算 E i E^i Ei和所有 e t i e^i_t eti之间的点积来估计置信度得分。我们使用这个置信度得分作为一个时间注意来找出哪些帧需要更多地参考。置信度计算如下:

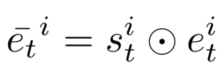

其中◦是点积,s是置信度。θ和δ为1×1卷积层。为了更加关注高置信度的帧,我们将该值乘以原始编码特征 e t i e^i_t eti,如下:

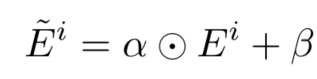

进一步将时空加权的信息层和时间加权层设计成卷积编码层。金字塔卷积可以有效地扩大感受野,只需很少的卷积层。然后,我们生成可学习的时空权重α,β。它将初始融合结果转化为隐式的对准学习。最终融合特征计算如下:

中间特征插值

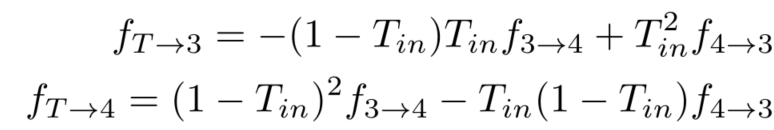

利用流估计器估计的光流,通过扭曲输入帧(X3、X4)的特征来合成中间帧的特征。为了减少计算量,本文对两个输入的编码特征进行扭曲,以产生目标中间特征。我们首先使用由PWC网络计算光流,然后使用以下公式来估计输入帧和中间帧:

f表示光流, T i n T_{in} Tin为系数值,提供中间帧的时间索引(例如,当我们想要得到 Y ^ 3.5 \hat Y_{3.5} Y^3.5时, T i n T_{in} Tin设为0.5)。中间帧的特征计算如下:

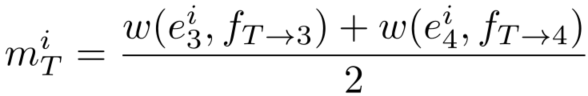

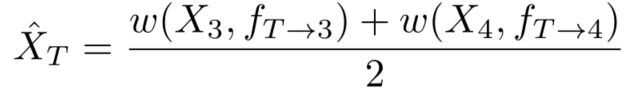

其中w代表扭曲。同时,我们为后续双线性上采样过程生成LR中间帧 X T X_T XT:

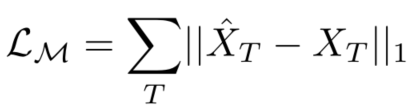

上述部分的损失函数为:

解码器

解码器重建目标HR残差图像,由多个密集的卷积块组成。相同数量的块用于连接编码器的每个块。为了生成目标帧的残差图像,最后一个块最后一层的特征使用shuffle将输出上采样。

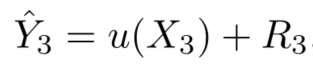

对于空间上采样, e 3 e_3 e3和 E ~ \tilde E E~用作输入。输出残差图像 R 3 R_3 R3被添加到上采样的目标帧以生成最终的HR输出,如下所示:

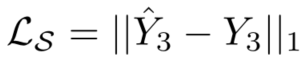

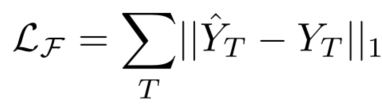

u(·)是双线性上采样函数,损失函数如下:

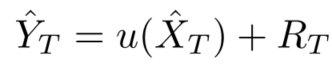

在空间上采样任务中,解码后的特征数据在每个密集块的末尾生成并转发给时空上采样任务以更丰富的信息作为补充。对于时空上采样,中间特征将传递给另一个共享权重的解码器。在这里,与空间上采样不同,解码特征是用 D i D^i Di代替 E ~ \tilde E E~:

损失为:

实验

数据集

本文从YouTube上收集240帧/秒的训练视频。该训练数据集由具有全局摄影机运动和局部对象运动的各种场景组成。数据集总共包含1800个视频片段和220K帧。为了制作LR帧,首先用高斯滤波器平滑HR帧,然后根据比例因子r=4进行二次采样。对于数据扩充,使用随机左右翻转并旋转90/180度,此外,还颠倒序列的顺序以扩大训练数据集。整个训练和测试在RGB通道中进行。

对比

提出了两种基线方法(V→F和F→V),将VSR和FI结合起来,最终运行。对于V和F,我们分别使用了EDVR和DAIN,这两种方法都是最先进的公开代码方法。

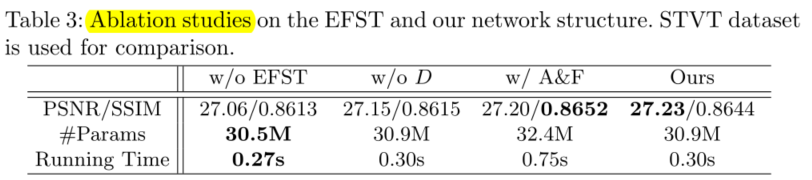

消融实验

本文仅做学术分享,如有侵权,请联系删文。请勿转载。

来源:oschina

链接:https://my.oschina.net/u/4364157/blog/4766980