“三个臭皮匠赛过诸葛亮”的理念在ensemble methods中体现的可谓淋漓尽致。在boosting中,adaboost是其中的代表。下面让我们简单领略adaboost背后的那些不可思议的要点......

1.adaboost的框架【adaboost提供的是一个算法框架】

2.原理简述

【分类问题】

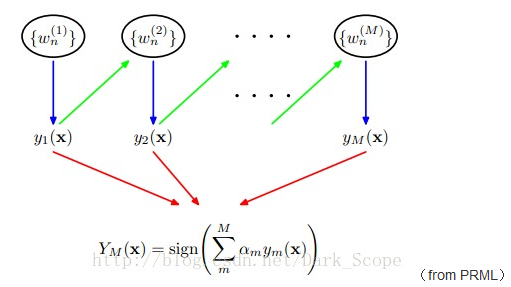

训练集D,样本权重w。基估计器(预测器)base estimator:G(x)【与框架中的y(x)相对应】。

adaboost通过G(x)【训练得到G(x)】对D进行预测(分类),那些被误分类的样本的权重会被提高,在进入下一轮训练时,分类器会特别“关照”那些权重高的样本,这样再次分类时,误分类的样本数量【误分类绿率】就会下降,直至为0.此时也会得到相应的M个弱分类器,最终通过分类器的权重进行线性组合,得到一个最终的boss。

熟悉adaboost的读者,相信你对adaboost算法的流程已经熟记于心,它就是这么吊!

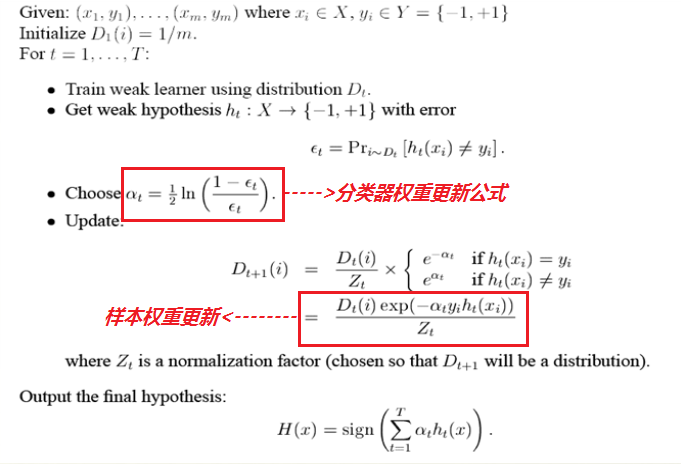

【adaboost算法流程】

可以看出,adaboost的原理在其算法流程中也体现的很清晰。

3.adaboost另一种解释

adaboost的另一个解释是模型为加法模型、损失函数是指数函数、学习算法为前向分步算法时的二分类学习方法。

可以在此基础下,推导出在adaboost中的分类器权重更新的公式以及样本权重更新的公式!相信,你会豁然开朗!

【具体推导详见:李航《统计学习方法》p144-p146】

pdf下载链接:http://www.dataguru.cn/forum.php?mod=viewthread&tid=283660

来源:oschina

链接:https://my.oschina.net/u/1774994/blog/300779