集合语义空间提高动提取同义词能力

- 文章出发点:医学界需要统一医学文章的专用词语言,从而针对医学文本同义词提取精度有限的问题,进行提高同义词从其他语义关系中分离开的能力。

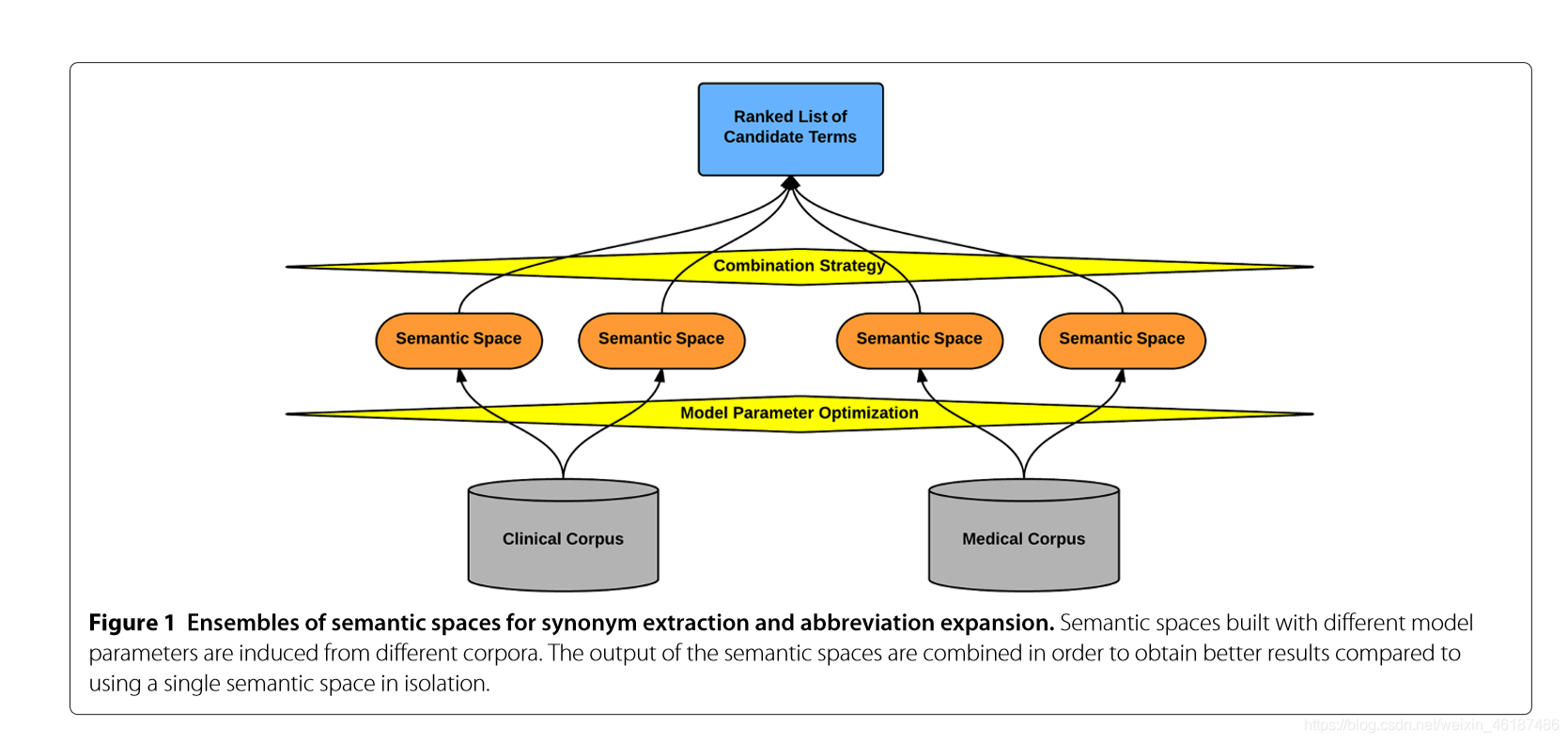

- 方法概括:(1)语料库预处理 (2)从两个语料库(和联合语料库)构建语义空间,(3)识别最有利的单个语料库(和联合语料库))组合,(4)识别最有利(不相交)的多语料组合,(5)单个语料库(包括联合语料库)和多个语料库组合的评估,(6)候选术语的后处理,和(7)频率阈值实验。

- 具体步骤:

运用材料:(1)临床语料库,包括健康记录的注释,和 (2)医学语料库,包括医学期刊文章

主要概念:RI随机索引:RI是LSA的增量,通过分配稀疏的、内部的和随机生成的d维索引向量来实现 给予某一术语静态的唯一表示值,为每个唯一术语分配相同维度d的初始空上下文向量。然后通过添加目标术语出现的上下文的(加权)索引向量,用上下文信息递增地填充上下文向量。

【然而LSA是什么呢】LSA是潜在语义分析,具体说来就是对一个大型的文档集合使用一个合理的维度建模,并将词和文档都表示到该空间,而将文档表示到此空间的过程就是SVD奇异值分解和降维的过程。

具体的做法是将词项文档矩阵做SVD分解,其中是以词项(terms)为行, 文档(documents)为列做一个大矩阵. 设一共有t行d列, 矩阵的元素为词项的tf-idf值。然后把的r个对角元素的前k个保留(最大的k个保留), 后面最小的r-k个奇异值置0, 得到;最后计算一个近似的分解矩阵,则在最小二乘意义下是的最佳逼近。由于最多包含k个非零元素,所以的秩不超过k。通过在SVD分解近似,我们将原始的向量转化成一个低维隐含语义空间中,起到了特征降维的作用。每个奇异值对应的是每个“语义”维度的权重,将不太重要的权重置为0,只保留最重要的维度信息,去掉一些信息“nosie”,因而可以得到文档的一种更优表示形式。【这段我看懂了,但我实在概括不下来】

【然而SVD奇异值分解和降维又是什么呢】【这个我研究了一下午,步骤非常繁琐,不知道可不可以引用其他博主的文,好想把链接直接放上来】

RP随机排列:RP是RI的修改,其通过在将索引向量添加到上下文向量之前简单地置换(即移位)索引向量中的元素根据它们的方向和与目标项的距离来编码项顺序信息。

一、从临床和医学语料库中诱导语义空间

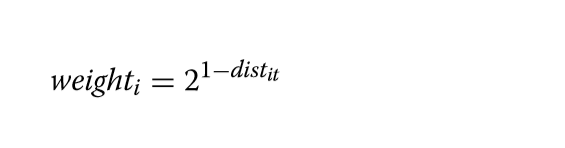

每个单独的语义空间使用一种模型类型构建,使用预定义的上下文窗口大小并从单个语料库类型诱导。使用JavaSDM[49](文章用的是java)用随机索引(RI)和随机排列(RP)构造语义空间。对于所有语义空间,使用1000的维度(在索引向量中具有8个非零,随机分布的元素:4个1和4个-1)。当使用RI模型时,索引向量根据它们与目标项的距离进行加权,即下式,其中distit是到目标项的距离。当采用RP模型时,索引向量的元素反而根据它们与目标项的方向和距离移位;不执行加权。

对于所有模型,使用围绕术语的两个(1+1),四个(2+2)和八个(4+4)的窗口大小。此外,为了研究显着更宽的上下文定义是否可能有利,诱导窗口大小为20(10+10)的RI空间。

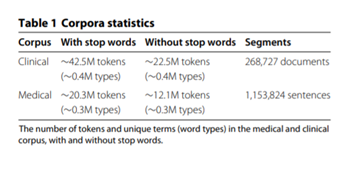

创建每个语料库的两个版本:一个保留终止词的版本和一个删除它们的版本

两个语料库的统计数据如表1所示。总共诱导了30个语义空间-每种语料库类型10个,联合语料库10个。从每种语料库类型(总共12个)诱导四个RI空间,差异是使用的上下文定义(1+1,2+2,4+4,10+10)。从每种语料库类型(总共18个)产生六个RP空间,差异是使用的上下文定义(1+1,2+2,4+4)以及停止词是否已被删除或保留(sw)。

二、来自单个语料库的语义空间的组合

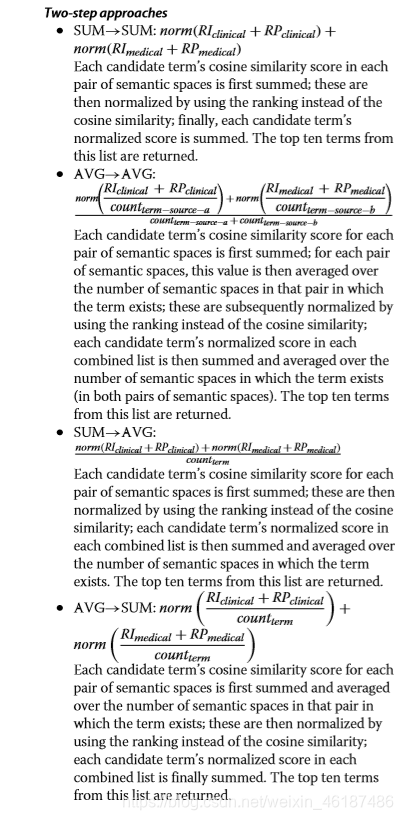

因为组合RI和RP空间可以增强捕获同义词的可能性,于是设计和评估了将基于RI的语义空间与RP空间组合的三种不同策略。对每个语料库评估30种组合,即总共60种(表2)。三种组合策略是:

•RI⊂RP30 找到RI空间中排名前十位的术语,这些术语属于RP空间中排名前三十位的术语。

•RP⊂RI30 找到RP空间中排名前十位的术语,这些术语属于RI空间中排名前三十位的术语。

•RI+RP 对每个候选项的两个空间中的余弦相似性得分求和

前两种策略根据给定的查询生成单词的初始排名。然后使用在相同语料库上训练的另一种模型类型根据其内部排名重新排列第一模型产生的前30个单词。

第三种策略(RI+RP)中,我们应用生成的相似性分数的直接求和。

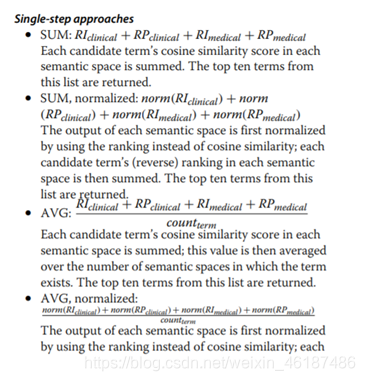

三、 来自多个语料库的语义空间的组合

除了组合从一个和同一个语料库诱导的语义空间之外,从多个语料库诱导的语义空间的组合可能在提取同义词和缩写扩展对的任务上产生甚至更好的性能,组合策略可以有效地分为两组方法

第一个方法是一步到位的方法

首先通过使用排序而不是余弦相似性来对每个语义空间的输出进行归一化;然后将每个候选术语在每个语义空间中的归一化分数求和;最后将该值平均在该术语存在的语义空间的数量上。返回此列表中的前十个术语。

下面是两步的

【写到这里的时候我意识到了一个问题,那就是这篇文章并没有像其他同学的那样细讲每一步,并且在处理上直接上升到几个大库的同义词处理,并且后面两个步骤文章中并没有确切的步骤描述,而是直接讨论了运用上述两组方法处理完数据,于是,转变心态,开始做摘抄…】

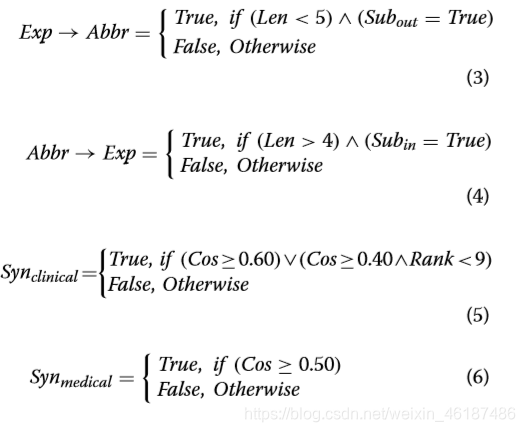

四、候选词的后处理

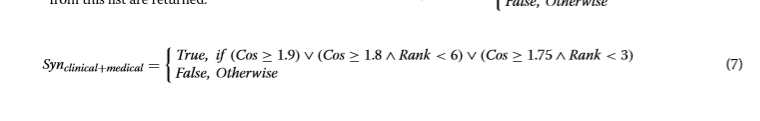

对于同义词提取,已使用秩和余弦相似性的截止值。这些截止值在不影响回忆的情况下,被设置为引用标准的开发子集合中最佳语义空间组合的最大化指定(见图2、3和4)。对于临床语料,使用的截止值如等式5所示,对于医学语料库,并在公式7中为两个语料库的组合。在等式7中,cos表示余弦值的组合,这意味着它的最大值为4,而不是1。

【然后就是基于上述研究的调试了这一段我就更懵了,太高深了,我觉得也跟我没有很好地理解RI和RP的形态有关,感觉整个文章研究的东西在我脑子里还是很抽象,看了一下午,觉得第七步探究步还是不知从何下手,太崩溃了。】

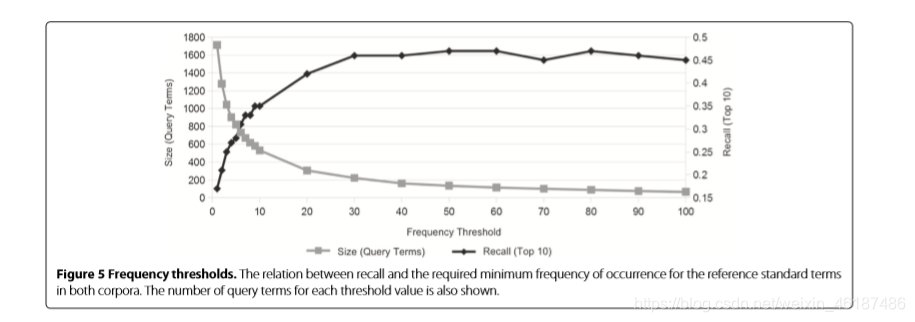

五 、频率阈值实验

还是概括一下我理解的第七步,该步是将RI和RP整理完,利用余弦相似性的排列,调整阈值以取到两个语料库中的引用和术语的调用和所需的最小发生频率,并以此讨论其之间的关系。

总结

以上是我的文章总结笔记了,作为第一次看论文写读后笔记,我觉得挺失败的,首先是在看论文时候没有先粗略浏览全文而是直接从要点开始死磕,结果开始套娃似的各种百度学下来也云里雾里,看到群里面大家的博客后才意识到自己看的论文可能并不能很好地贴切这次研讨的问题,这个方法给我的感觉就是它不难但没理解透最基础几个观念就很难开始读懂它,第二点是耐心问题,看到长篇的文章就有点发怵,不敢下手,有一种 不会也可以 的潜意识,这也是到了文章最后一步啥也看不懂的最大原因吧。而这些问题出现的原因,就是我轻率地直接拿了篇文章就自个研究而不去询问有经验的教授还有其他小姐姐,至少了解一下学习论文的流程给自己心里打个谱啊…总而言之,是一次很惨痛的教训了。

来源:CSDN

作者:Hinako_

链接:https://blog.csdn.net/weixin_46187486/article/details/104823692