神经网络中,会得到w0,w1,...wn,这些是各个特征的权重,如果输出output = w0x0+w1x1+...+wnxn 则训练得到的是特征的线性组合,如果只是线性组合,我们完全可以去掉所有隐藏层。

事实上,有很多情况下,特征与输出之间的关系是非线性的,所以我们需要一个通用的,可以逼近所有(线性与非线性)关系的网络

引入非线性激活函数的原因就在这里。

深度学习中,激活函数通常指能够实现非线性映射的函数

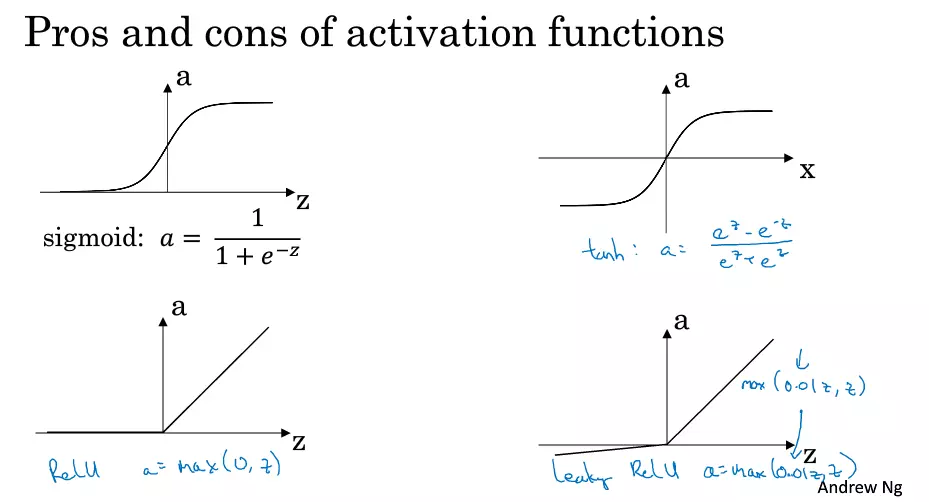

常见激活函数:

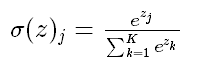

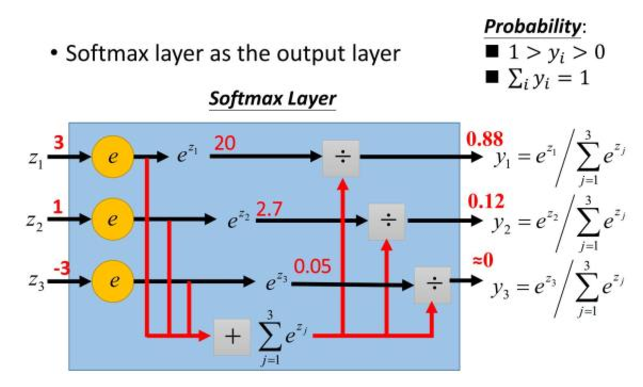

softmax函数

使用方法:

1、不同层的激活函数可以是不一样的。

2、sigmoid函数一般只用在2分类的输出层,且结果与softmax激活函数输出相同,我一般习惯统一使用softmax

3、ReLU (修正线性单元 Rectified Linear Unit) 最常用 y = max(0,x)

4\