ResNet

Deep Residual Learning for Image Recognition

Abstract & Introduction

深层网络具有难以训练的特点,例如,出现梯度弥散/爆炸(这件事通过初始值正则化和BN层解决了)

另一个困难是,当层数过高时,准确率达到饱和后开始迅速下降,而这并非是由过拟合造成,而是由于优化过程造成;在本文中,通过引入deep residual learning framework 来解决该问题

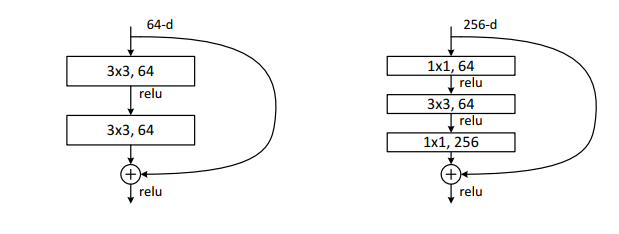

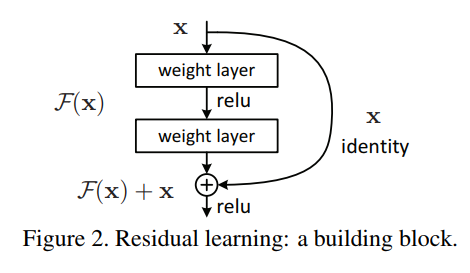

想法是优化残差 $ F(x)=H(x)-x $

$ y = F(x, {W_i}) + W_sx $ ,仅当需要调节维度时 $W_s \neq 0 $

F(x)与x 直接相加,没有引入新的参数,保证了计算速度

以上操作不仅可以用于线性层,还能用于卷积层

Related Work

Residual Representation

残差编码; 多重网格法解PDE

Shortcut Connections

通过将input和output做element-wise的直接相加,加快了训练速度

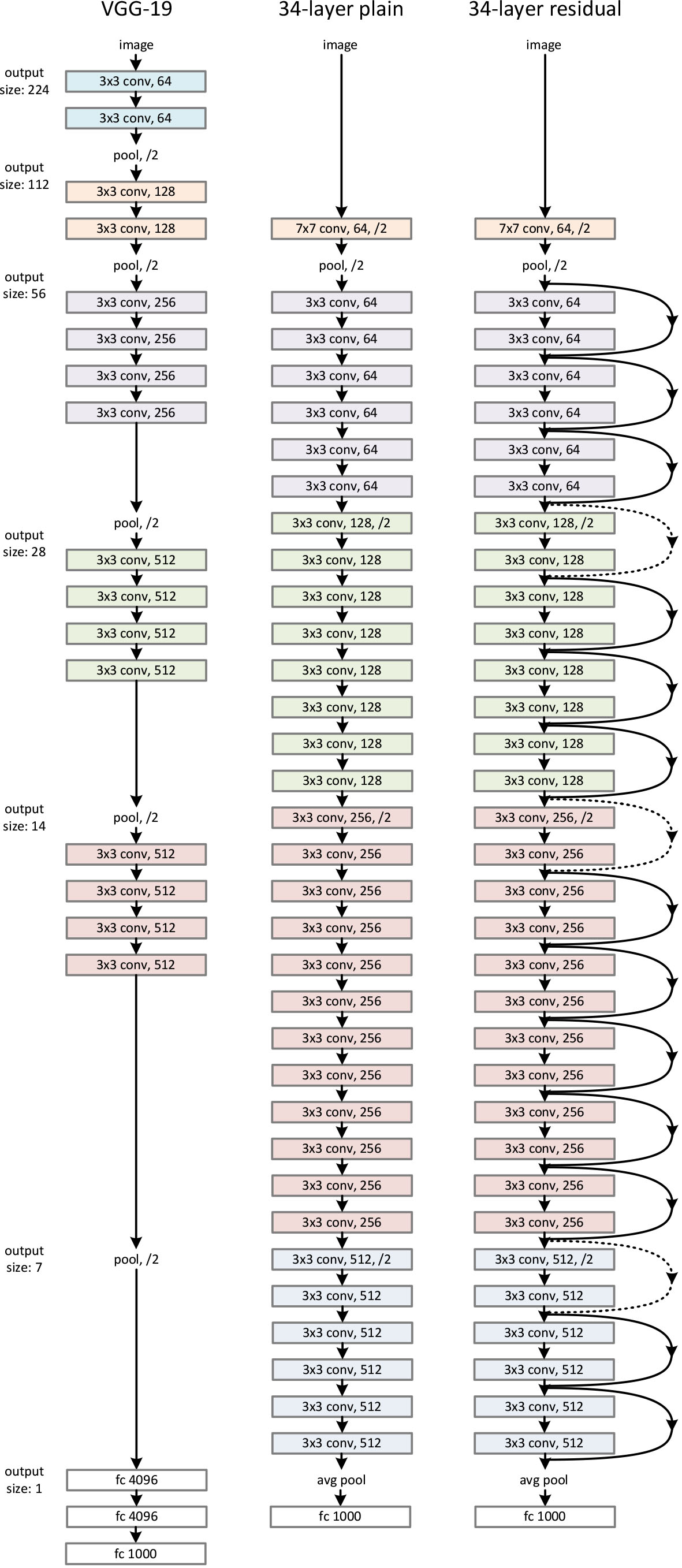

Architecture

Shortcut 的3种方式:

- 使用线性投影

- 使用恒等投影,不足处补零

- 维度一致时使用恒等投影,否则使用线性投影

实验结果表明使用线性投影可以使准确率略有提升但相差不大,故通常使用更为经济的方法2

更深的residual block