实现步骤:

1)搭建好Hadoop(版本,2.7)集群

2)安装和配置scala(版本,2.11)

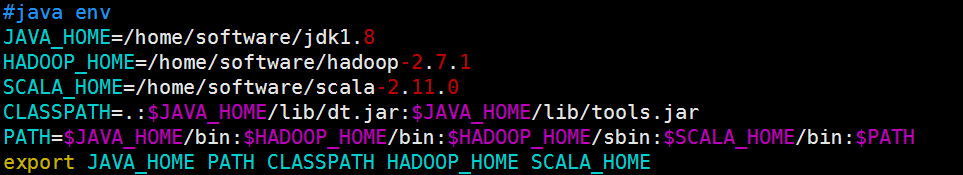

上传解压scala-2.11.0.tgz—>配置 /etc/profile文件

配置信息如下:

3)在NodeManager节点(01,02,03节点)上安装和配置Spark

4)进入Spark安装目录的Conf目录,配置:spark-env.sh 文件

配置如下:

export JAVA_HOME=/home/software/jdk1.8

export SCALA_HOME=/home/software/scala-2.11.0

export HADOOP_HOME=/home/software/hadoop-2.7.1

export HADOOP_CONF_DIR=/home/software/hadoop-2.7.1/etc/hadoop

5)配置:slaves文件

配置如下:

hadoop01

hadoop02

hadoop03

6)在HDFS上,创建一个目录,用来存放 spark的依赖jar包

执行: hadoop fs -mkdir /spark_jars

7)进入spark 安装目录的jars目录,

执行:hadoop fs -put ./* /spark_jars

8)进入spark安装目录的 conf目录,配置:spark-defaults.conf 文件

配置师例:

spark.yarn.jars=hdfs://hadoop02:9000/spark_jars/*

9)至此,完成Spark-Yarn的配置。注意:如果是用虚拟机搭建,可能会由于虚拟机内存过小而导致启动失败,比如内存资源过小,yarn会直接kill掉进程导致rpc连接失败。所以,我们还需要配置Hadoop的yarn-site.xml文件,加入如下两项配置:

yarn-site.xml配置示例:

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

10)启动Hadoop的yarn,进入Hadoop安装目录的sbin目录

执行:sh start-yarn.sh

11)启动spark shell,进入Spark安装目录的bin目录

执行:sh spark-shell --master yarn-client

然后可以通过yarn控制台来验证

至于spark的使用,和之前都是一样的。只不过资源的分配和管理是交给yarn来控制了。

来源:oschina

链接:https://my.oschina.net/u/3701483/blog/3017189