spark-shell作为交互式本地调试spark程序的利器,非常有用。

看看怎么上手吧,首先下载最新版的spark,这里下载的是spark 3.0版本。

然后执行bin\spark-shell脚本,进入交互环境:

scala> spark.range(1000*1000).count()

测试一下spark-shell是否正常工作,能显示出来就表示没问题。

接着看看怎么连mysql,这里我们尝试读取本地mysql数据库test库的people表。

首先设置链接参数:

scala>val conf=Map("url" -> "jdbc:mysql://127.0.0.1:3306/test", "driver" -> "com.mysql.jdbc.Driver", "dbtable" -> "person", "user" -> "root", "password" -> "123456")

然后载入DataFrameReader:

scala>val peopleDF=sparl.read.format("jdbc").options(conf).load()

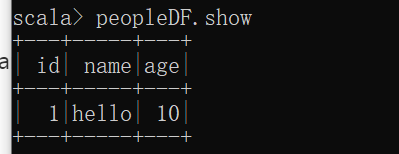

scala> peopleDF.show

显示这个,表示读取mysql成功了!!

来源:oschina

链接:https://my.oschina.net/u/778683/blog/4298722