本论文由腾讯 AI Lab 主导,和厦门大学、西湖大学合作完成。作者提出基于“多视角重建”的损失函数提升文本生成的质量和忠实度,与此同时并没有增加任何模型参数。

Structural Information Preserving for Graph-to-Text Generation

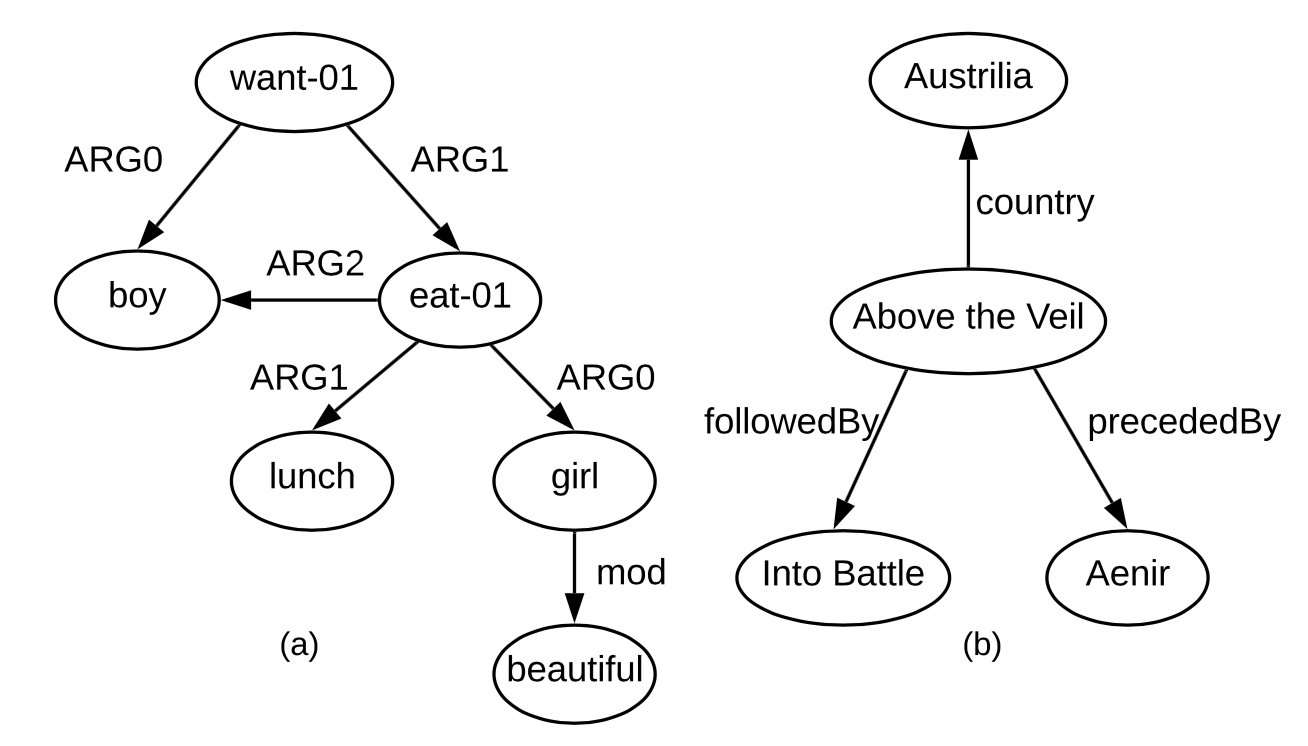

图到文本生成(graph-to-text generation)任务有着广泛的潜在应用,并且已经被应用在机器翻译等任务中。下图显示了两种图结构(语义图和知识图谱),分别表示“The boy wants the beautiful girl to eat lunch with him.”和“Above the Veil is an Australian novel and the sequel to Aenir. It was followed by Into the Battle.”

现有的该领域工作不断的提出更强大的模型来表示图信息,但模型依然是通过拟合到目标文本的基于语言模型(language modeling loss)的损失函数进行训练的,作为结果,模型会产生流畅的输出,但会丢失许多输入的重要信息。

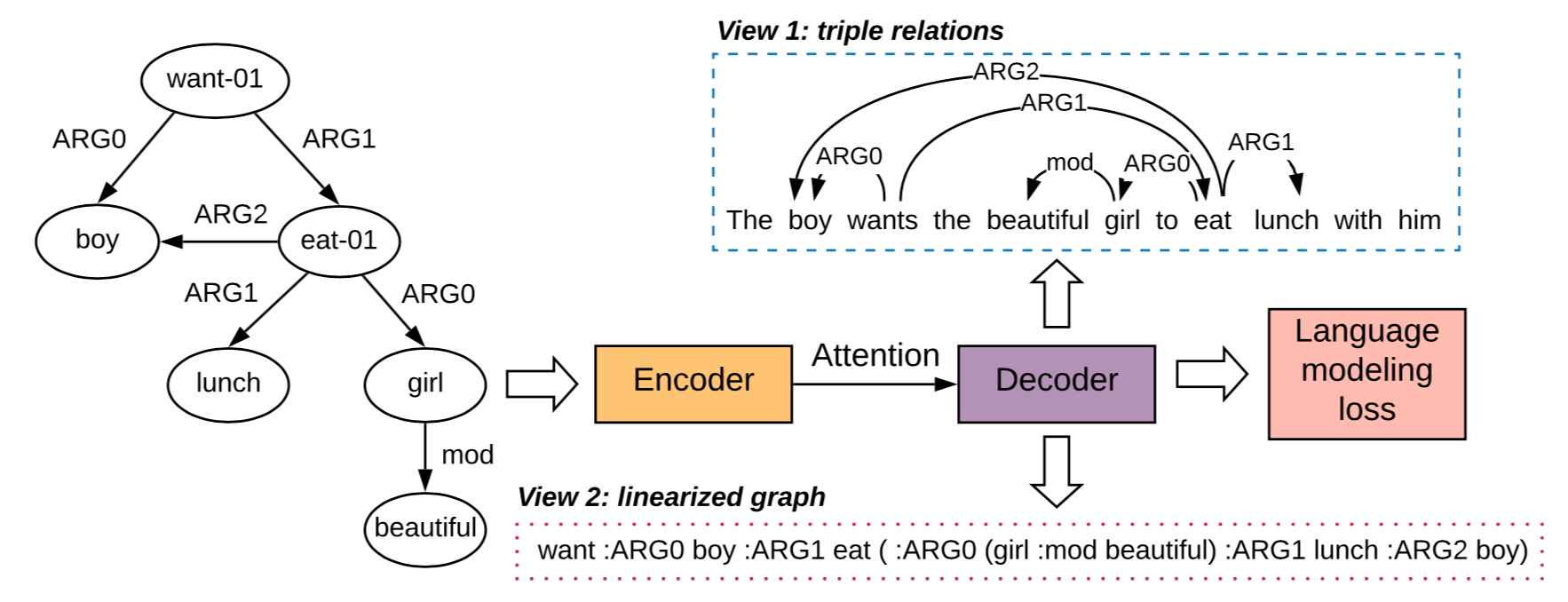

本文提出了一种通用的基于“多视角重建”的损失函数来辅助模型训练。总的来说,我们提出了多种方法把输入的图投射到目标句子端,让解码器不仅学习输出目标句子,还要输出投射的图结构,这样能够迫使模型在做生成的时候更好的记住输入内容。

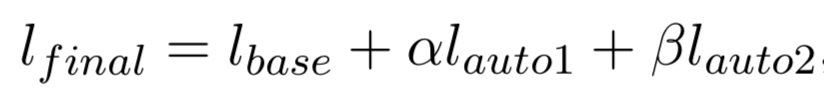

上图展示了我们的模型,其中“Encoder-Decoder”代表一种“structural-aware transformer” 的模型,它在多个图到文本生成任务重取得了最好的性能,它用右侧的基于语言模型的损失函数来训练。我们提出两种“多视角重建”的损失函数,它们都是从解码器端进行计算,这样能够强化整个模型的训练(而不是只有编码器)。其中第一种视角(View 1)展现了图投射在目标语言上的形态,它类似于依存树,我们用额外的Deep Baffine模型对它进行建模;另外第二种视角(View 2)展示了线性化后的图,我们用一个标准的饿Transformer Decoder对它进行建模,最后对三部分损失加权得到最终的损失:

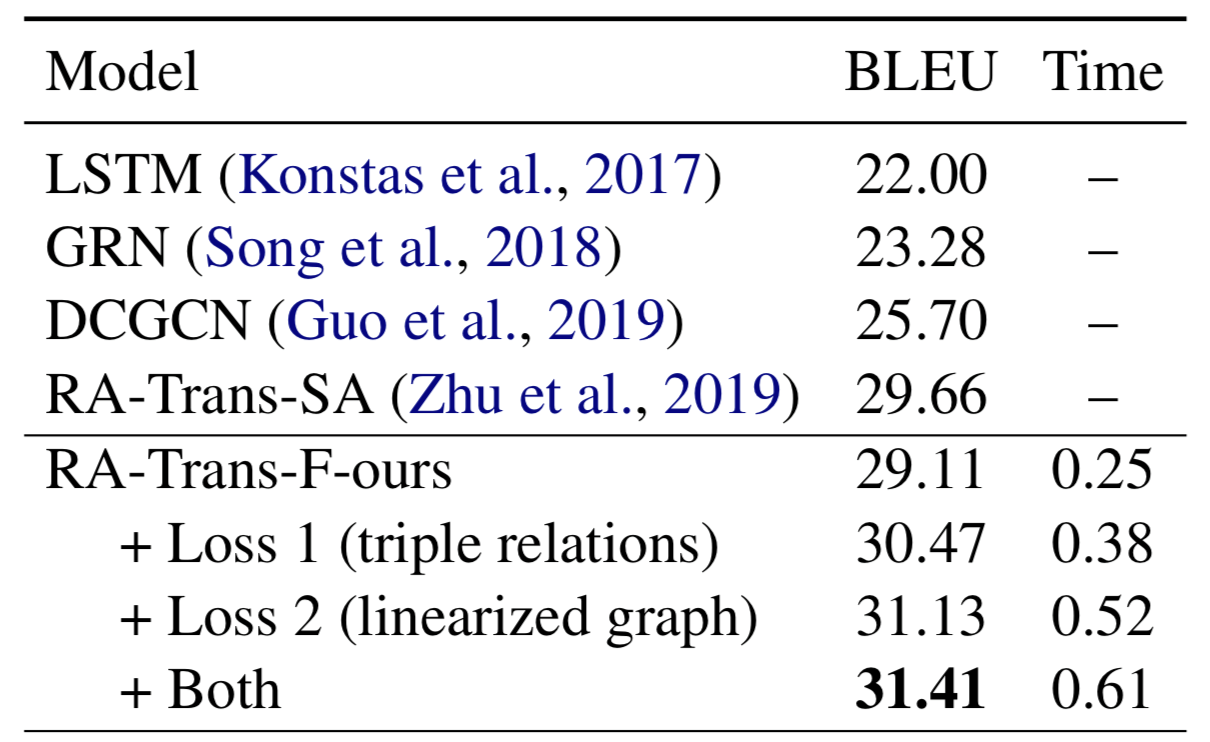

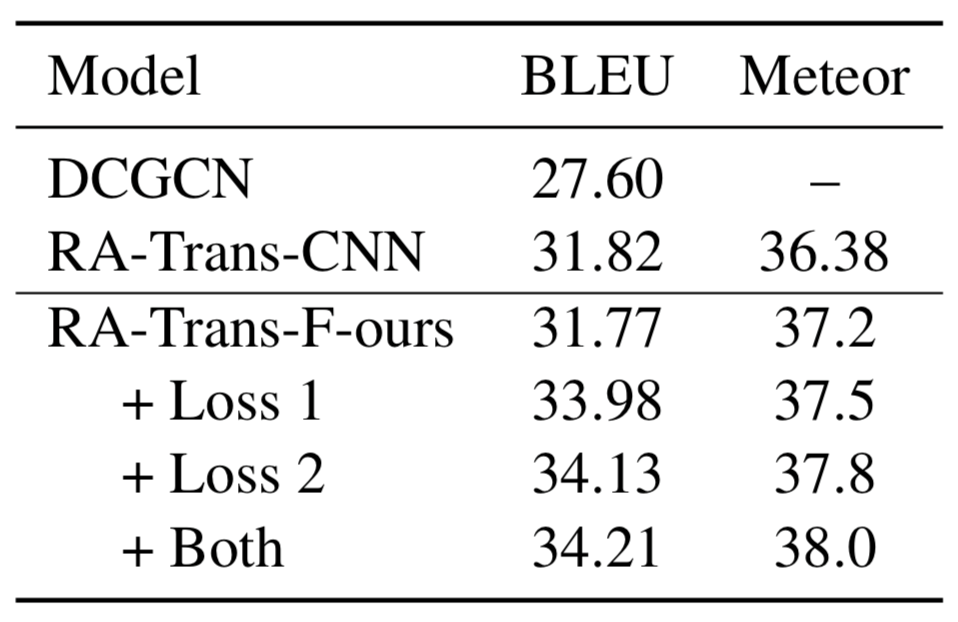

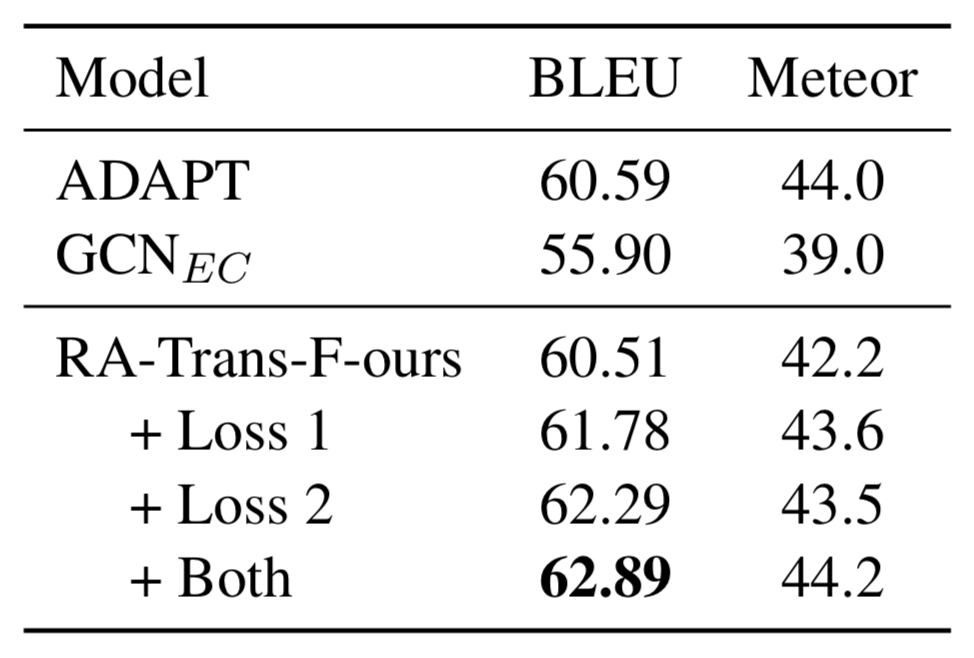

为了验证作者在三个图到文本的标准数据集(LDC2015E86,LDC2017T10,WebNLG)上进行验证,分别取得了2.4+ BLEU score的提升,分别见表1、2、3,更多分析结果请参考原文

表1: LDC2015E86上的结果

表2: LDC2017T10上的结果

表3: WebNLG上的结果

来源:oschina

链接:https://my.oschina.net/u/4518196/blog/4443448