以下我们要进行:

1、搭建hadoop伪分布式模式,启动hdfs

2、上传文档到hdfs

3、对hdfs里面的文档进行词频分析

首先:

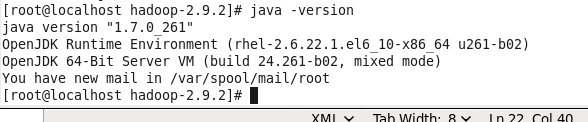

1、确保jdk安装正确

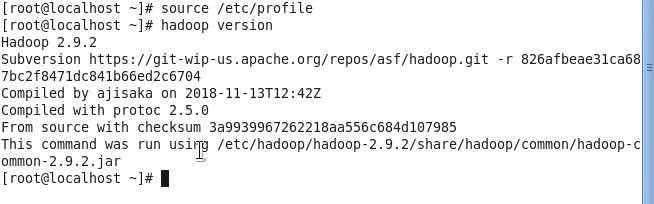

2、确保安装并配置hadoop

,以下是hadoop的版本

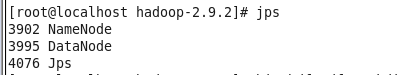

通过第四讲的配置启动hadoop服务,输入jps可以查看到

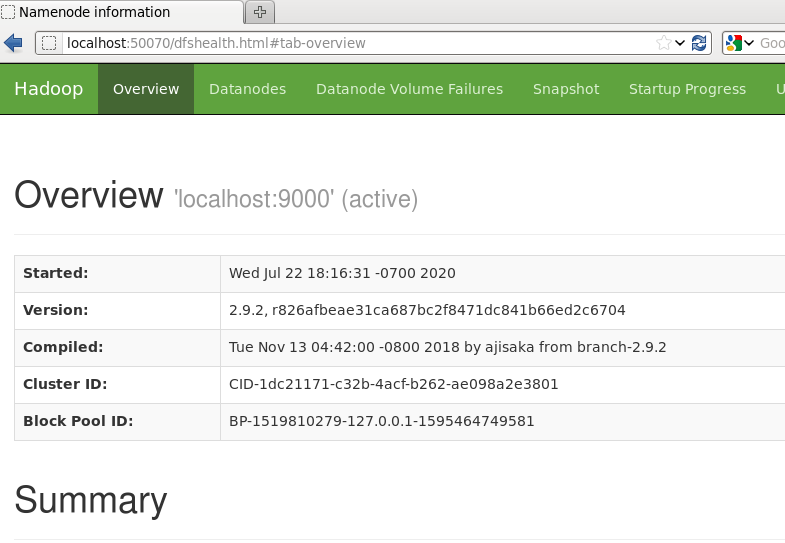

3、确保hdfs正常运行

,通过网页可以查看到hdfs页面数据:在浏览器输入:localhost:50070

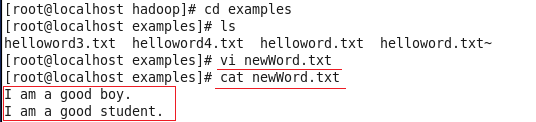

4、新建一个本地文件

,并且上传到hdfs上面

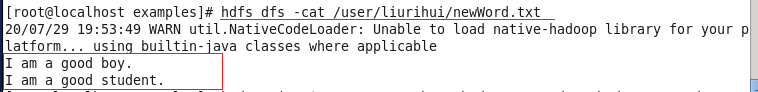

查看上传的文件内容:

5、使用命令进行词频分析

如果是hdfs已经启动的话,hadoop jar XXXX.jar wordcount 命令默认是访问hdfs里面的文件。

![]()

以上的命令:加入$hadoop_home ,系统会自动把配置文件里面的这个变量取出来,这样我就不需要cd进入到对应的文件夹,这里默认就是绝对路径了。

语句的意思:调用hadoop自带的hadoop-mapreduce-examples-2.9.2.jar 里面的wordcount 方法对hdfs里面的/user/liurihui/newWord.txt文档进行词频分析,分析结果存储在hdfs根目录下面的resultOut文件夹,系统会自动创建这个文件夹。

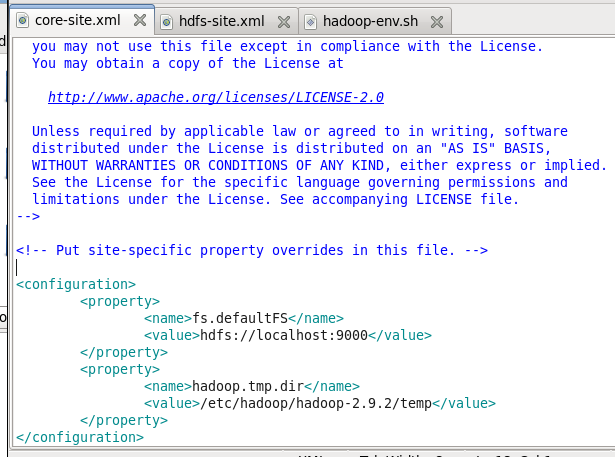

系统在词频分析的时候,我们看系统打印出来的日志,可以看到系统默认会在/user/liurihui/newWord.txt前面加上我们之前在core-site.xml里面配置hdfs路径:

![]()

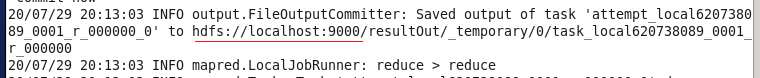

同样,我们查看打印的日志也可以看到,系统输出的时候也是加上我们之前在core-site.xml里面配置hdfs路径:

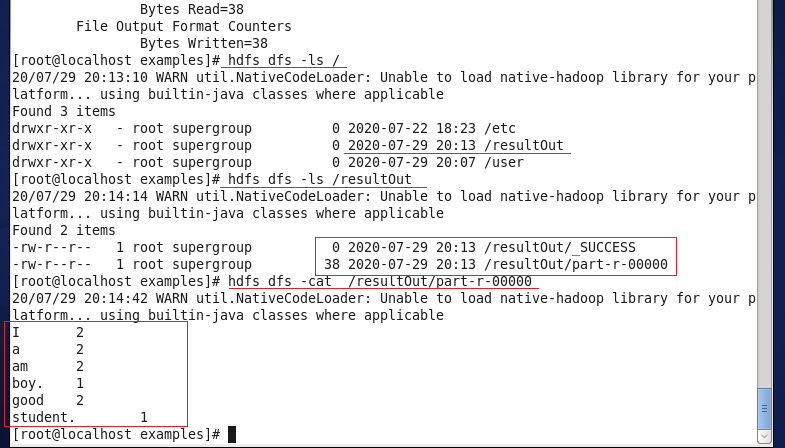

6、查看结果

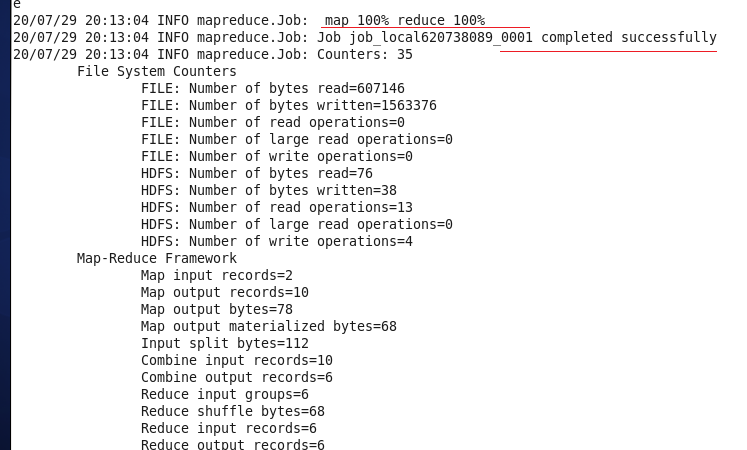

最终结果显示map和reduce都是100%则说明成功了。

我们可以进入hdfs目录查看结果,结果如下,系统在hdfs根目录下系统创建了resultOut文件夹,并且在文件夹里面有part-r-00000的结果文件,采用cat命令查看的时候,词频分析结果正确。:

来源:oschina

链接:https://my.oschina.net/u/4082616/blog/4455161