深度学习中Attention与全连接层的区别何在? - 哈哈哈的回答 - 知乎 https://www.zhihu.com/question/320174043/answer/1383690704

1.静态与动态权重的区别

全连接层中的权重,对于所有的样本,都是固定的、相同的;attention模式下的权重,对于不同的样本,则是不同的。

那么,在attention模型中,为什么要对不同的样本,施加不同的权重呢?

举个例子,在如下左边的图片中,鹰在图片的右上角;在右图中,鹰在图片的左下角。如果我们希望神经网络既能捕捉到左图中的鹰,又能捕捉到右图中的鹰,我们就希望神经网络能够根据每个样本的特点,对每个样本的不同部位,施加不同的权重。

2.Attention不一定是加权的形式

传统的attention,例如SENet,都是采用特征加权的形式,所以与全连接层比较相似。

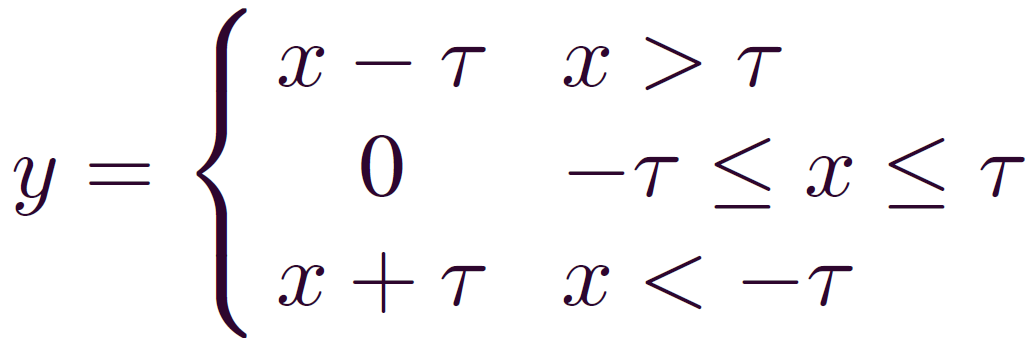

事实上,attention可以不是加权的形式,也可以是软阈值化的形式。

具体而言,attention可以用来生成软阈值化所需要的阈值,来进行特征的非线性变换,以应对各个样本中噪声含量不同的情况(残差收缩网络[1])。

参考

Minghang Zhao, Shisheng Zhong, Xuyun Fu, Baoping Tang, Michael Pecht, Deep residual shrinkage networks for fault diagnosis, IEEE Transactions on Industrial Informatics, 2020, 16(7): 4681-4690. https://ieeexplore.ieee.org/document/8850096

来源:oschina

链接:https://my.oschina.net/u/4488089/blog/4469456