本机:win10

python3.5.4

spark3.0.0

JDK13.0.1

scala2.13.1

hadoop2.7.7

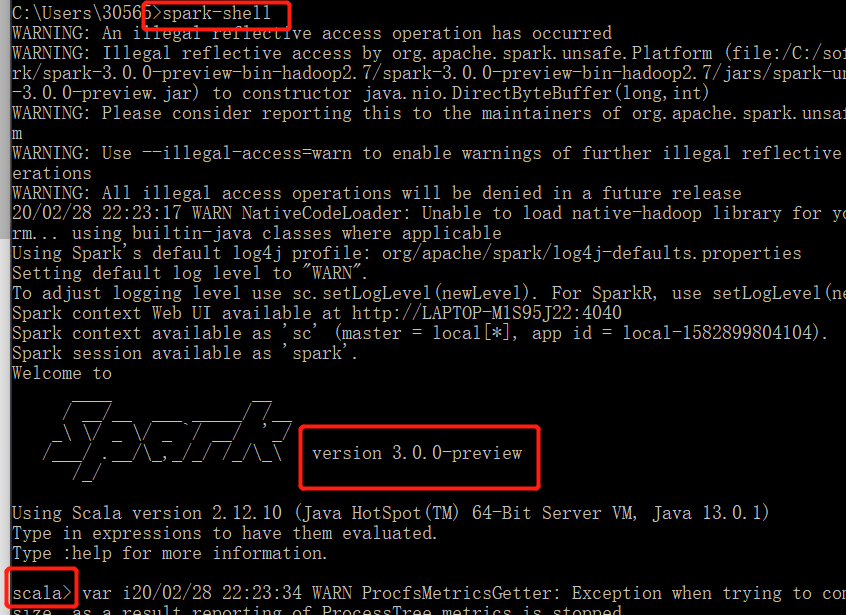

终端输入 spark-shell进入scala的shell

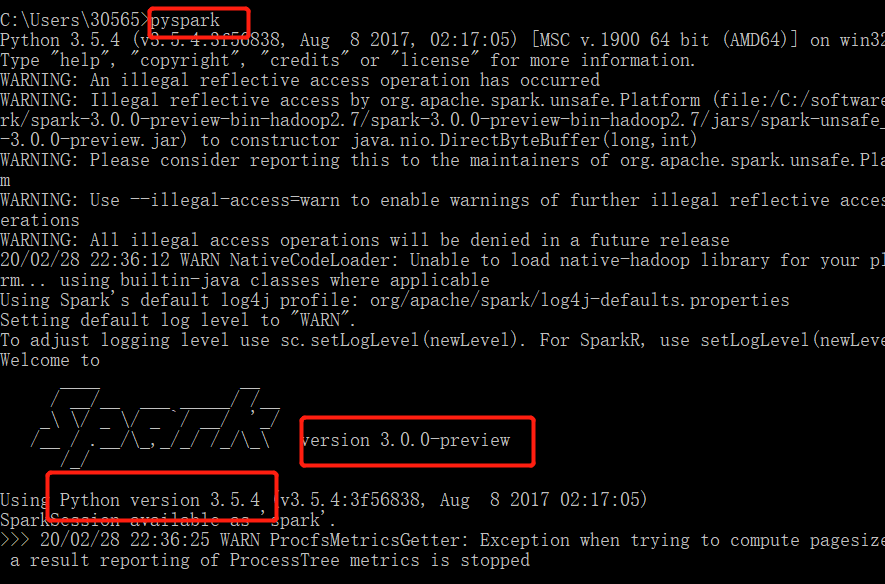

打开python版本的Spark shell,也就是PySpark shell

若没有配置spark环境需要:

进入你的spark目录然后输入:

bin\pyspark

若已经配置了spark环境

终端输入 pyspark 进入python

来源:https://www.cnblogs.com/ivyharding/p/12380929.html