引入注意力机制的seq2seq(编码器-解码器)

在之前的练习中,解码器在各个时间步依赖相同的背景变量(context vector)来获取输入的序列信息。当编码器为循环神经网络时,背景变量来自它最终时间步的隐藏状态。将源序列输入信息以循环单位状态编码,然后将其传递给解码器以生成目标序列。

然而这种结构存在着问题,尤其是RNN机制实际中存在长程梯度消失的问题,对于较长的句子,我们很难寄希望于将输入的序列转化为定长的向量而保存所有的有效信息,所以随着所需翻译句子的长度的增加,这种结构的效果会显著下降。

解码器只能隐式地从编码器的最终状态中选择相应的信息。然而,注意力机制可以将这种选择过程显式地建模。

注意力机制框架

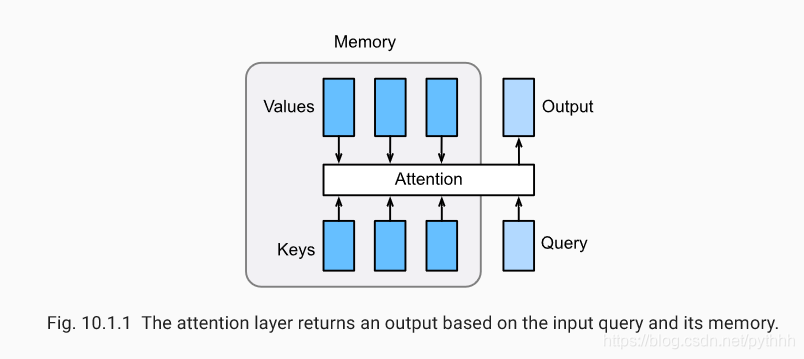

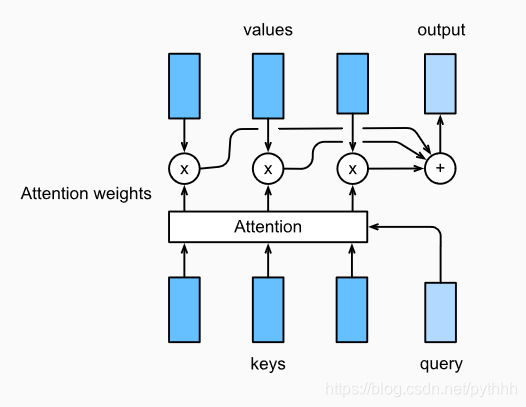

Attention 是一种通用的带权池化方法,输入由两部分构成:询问(query)和键值对(key-value pairs)。对于一个query来说,attention layer 会与每一个key计算注意力分数并进行权重的归一化,输出的向量则是value的加权求和,而每个key计算的权重与value一一对应

为了计算输出,我们首先假设有一个函数α用于计算query和key的相似性,然后可以计算所有的 attention scores ,

之后用Softmax函数将其归一化,获得注意力权重,

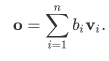

最终的输出就是value的加权求和:

不同的attetion layer的区别在于score函数的选择,在本节的其余部分,我们将讨论两个常用的注意层 Dot-product Attention 和 Multilayer Perceptron Attention;

代码部分

os模块:提供了多数操作系统的功能接口函数。,在python编程时,经常和文件、目录打交道,这时就离不了os模块.

os.walk()

函数声明:os.walk(top,topdown=True,οnerrοr=None)

(1)参数top表示需要遍历的顶级目录的路径。

(2)参数topdown的默认值是“True”表示首先返回顶级目录下的文件,然后再遍历子目录中的文件。当topdown的值为"False"时,表示先遍历子目录中的文件,然后再返回顶级目录下的文件。

(3)参数onerror默认值为"None",表示忽略文件遍历时的错误。如果不为空,则提供一个自定义函数提示错误信息后继续遍历或抛出异常中止遍历。

返回值:函数返回一个元组,含有三个元素。这三个元素分别是:每次遍历的路径名、路径下子目录列表、目录下文件列表。

来源:CSDN

作者:pythhh

链接:https://blog.csdn.net/pythhh/article/details/104440388