1、身份认证

2、查看/user/g8bd6a3461f924456fdxe91p0 目录下文件

drwxrwx--x - backend g8bd6a3461f924456fdxe91p0 0 2020-01-06 19:02 /user/g8bd6a3461f924456fdxe91p0/9ed3572a-3cea-4ecb-a34e-d75df653d1af

发现有路径 /9ed3572a-3cea-4ecb-a34e-d75df653d1af

3、继续hdfs dfs -ls

发现下一级还有路径/tohdfs

drwxrwx--x - backend g8bd6a3461f924456fdxe91p0 0 2020-01-06 19:02 /user/g8bd6a3461f924456fdxe91p0/9ed3572a-3cea-4ecb-a34e-d75df653d1af/tohdfs

4、继续hdfs dfs -ls +路径

drwxrwx--x - backend g8bd6a3461f924456fdxe91p0 0 2020-01-06 19:02 /user/g8bd6a3461f924456fdxe91p0/9ed3572a-3cea-4ecb-a34e-d75df653d1af/tohdfs/2020-01-06

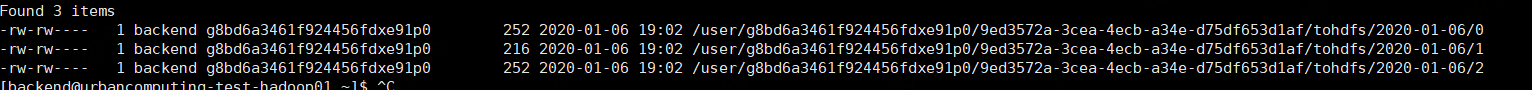

5、继续hdfs dfs -ls +路径

发现有三个文件

这就是hdfs离线同步后的数据文件。

解释一下为啥是三个文件:

0,1,2,是三个partition,这是在kafka配置的topic下面的partition数量(根据设计来,可以改配置)

然后根据日期区分每天的partition(上面截图的2020-01-06),

然后路径上一级加了/tohdfs,

再上一级路径是一串字符是topic,这里是根据task_id设计来的,实际就等于task_id(比如上面第一行数据的9ed3572a-3cea-4ecb-a34e-d75df653d1af);

然后上一级(比如第一行的g8bd6a3461f924456fdxe91p0就是uuid),这个uuid是从业务接口抓取的参数。一个机构组对应一个uuid。

程序设计不同,hdfs的文件路径不同。

hdfs dfs -cat(-text) /user/g8bd6a3461f924456fdxe91p0/9ed3572a-3cea-4ecb-a34e-d75df653d1af/tohdfs/2020-01-06/0

查看文件信息:

有7行json格式数据。

这就是hdfs数据存储。

来源:CSDN

作者:AMEI_2015

链接:https://blog.csdn.net/condoleeA/article/details/103865271