文章目录

一、下载

spark官网下载

http://spark.apache.org/downloads.html

从微软的镜像站下载

http://mirrors.hust.edu.cn/apache/

从清华的镜像站下载

https://mirrors.tuna.tsinghua.edu.cn/apache/

二、安装基础

1、jdk 安装成功 jdk安装教程

2、hadoop 安装成功 hadoop 安装搭建详解

3、Scala安装成功 scala 安装详解

三、Spark安装

1、上传并解压缩

cd /opt/soft

tar -zxvf spark-2.3.4-bin-hadoop2.6.tgz

mv spark-2.3.4-bin-hadoop2.6 /opt/soft/spark234

2、修改配置文件

cd /spark234/conf

[root@hw1 conf]# cp spark-env.sh.template spark-env.sh

[root@hw1 conf]# cp slaves.template slaves

[root@hw1 conf]# vi slaves

3、添加连接接点

localhost

hw2

hw3

4、添加运行环境

[root@hw1 conf]# vi spark-env.sh

// 找到 # - SPARK_DRIVER_MEMORY, Memory for Driver (e.g. 1000M, 2G) (Default: 1G)

// 下方添加

export SPARK_MASTER_HOST=192.168.56.122

export SPARK_MASTER_PORT=7077

export SPARK_WORKER_CORES=2

export SPARK_WORKER_MEMORY=5g

export SPARK_MASTER_WEBUI_PORT=9999

5、配置jdk

[root@hw1 sbin]# vi spark-config.sh

export JAVA_HOME=/opt/soft/jdk180

6、拷贝到从节点

[root@hw1 soft]# scp -r /opt/soft/spark234/ root@hw2:/opt/soft/

[root@hw1 soft]# scp -r /opt/soft/spark234/ root@hw3:/opt/soft/

7、启动 spark

(启动 start-all.sh 为了避免与 hadoop 冲突 未配置环境变量)

[root@hw1 soft]# cd spark234/sbin

[root@hw1 sbin]# ./start-all.sh

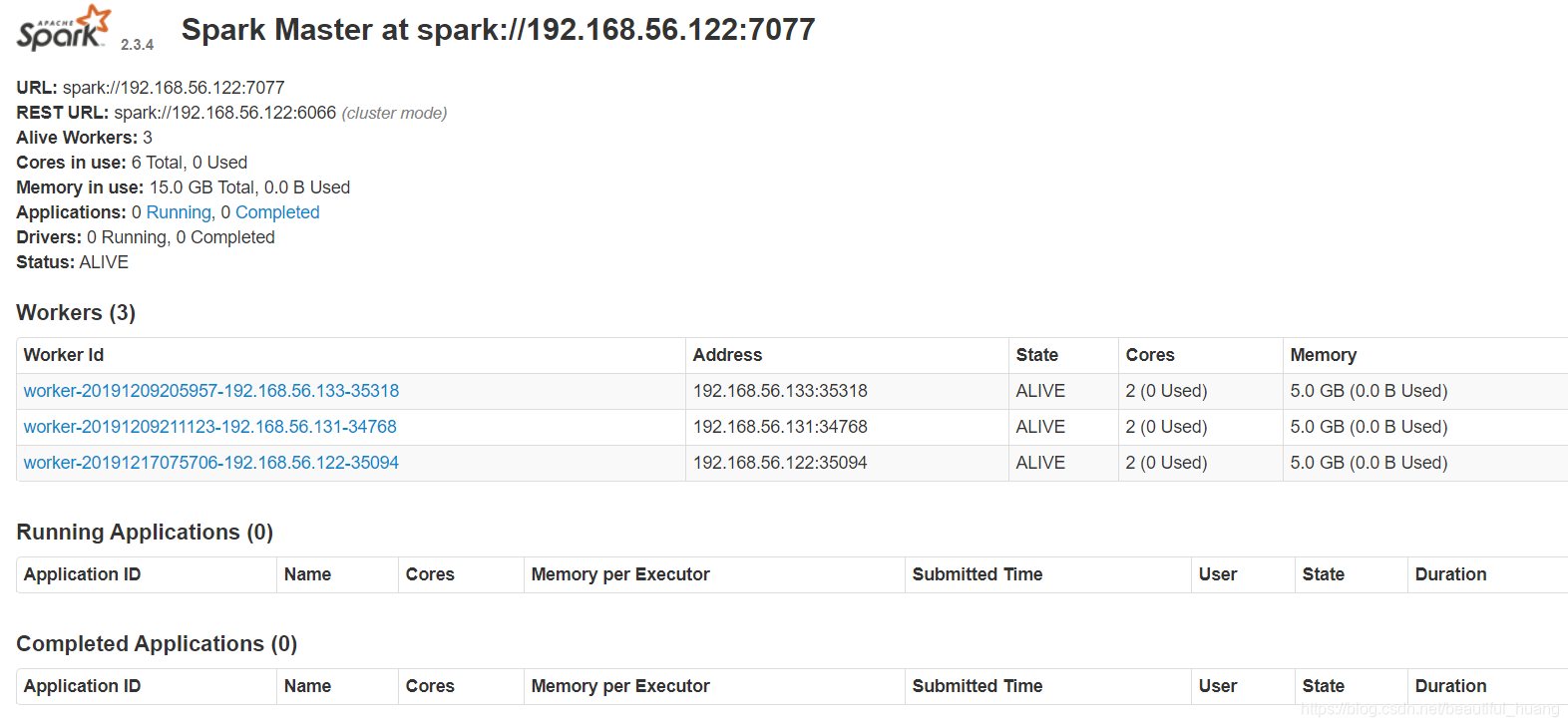

四、验证

1、查看Web界面Master状态

hadoop1是ALIVE状态,hadoop2、hadoop3和hadoop4均是STANDBY状态

来源:CSDN

作者:beautiful_huang

链接:https://blog.csdn.net/beautiful_huang/article/details/103809248