为什么要配置历史服务器

DriverProgram:客户端;提交一个应用程序(application)以后,再提交一次,就无法查看之前的提交信息了;使用历史服务器就可以

具体配置过程如下

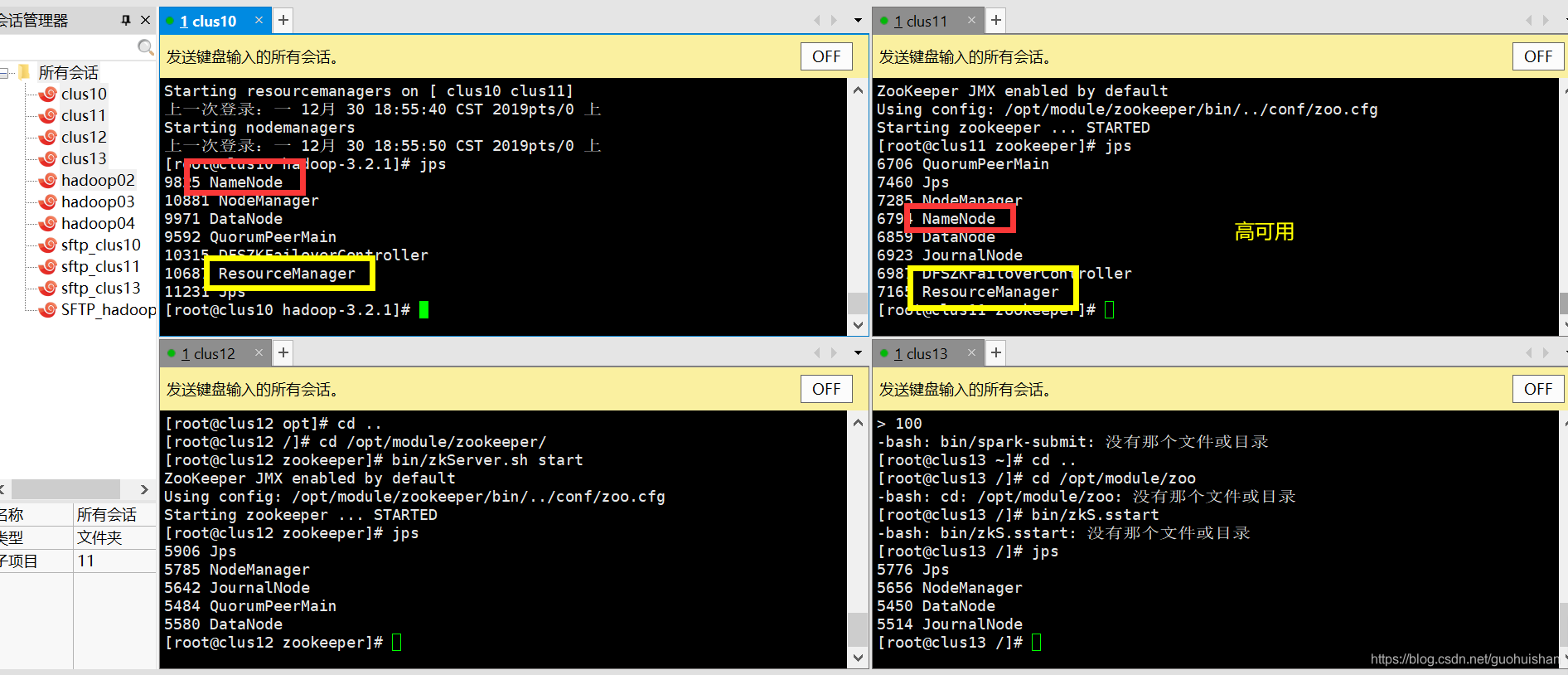

:现有客户机(clus10,clus11,clus12,clus13)

1.首先启动zookeeper

bin/zkServer.sh start

bin/zkServer.sh status

查看状态(一个leader,2个follower)表明正常运行。

2.启动hadoop集群

sbin/start-all.sh

jps

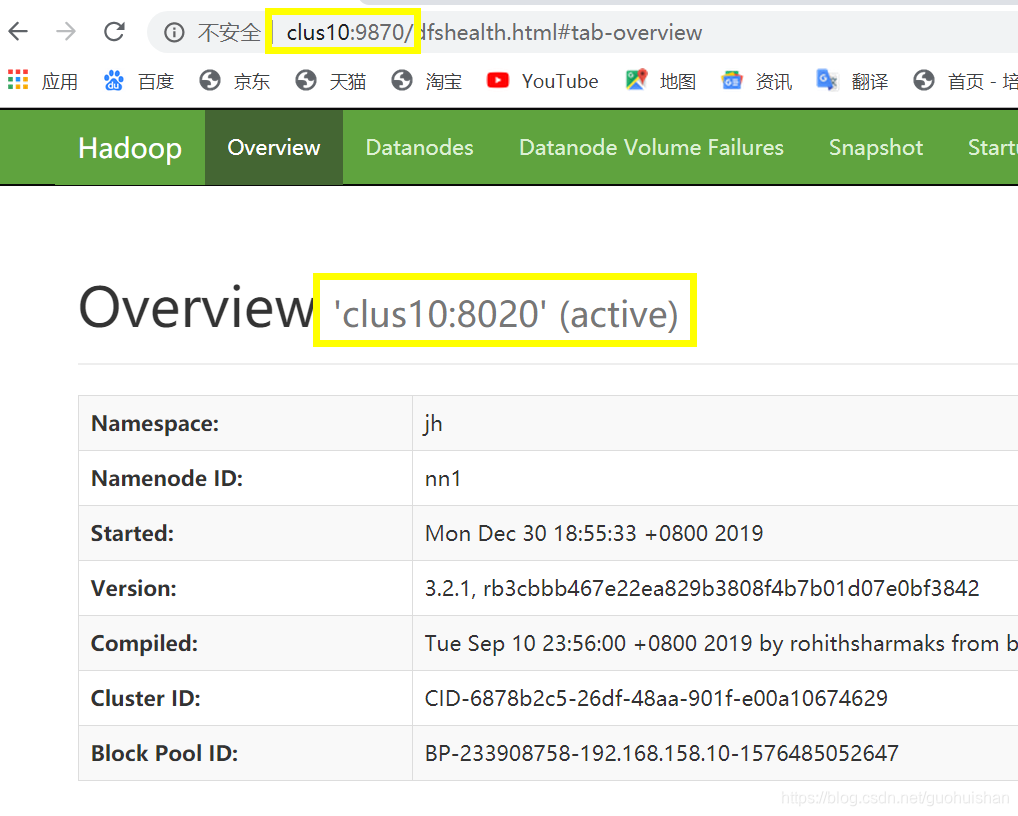

3.查看active的namenode

网址如下两个

clus10:9870

clus11:9870

4.查看active的resourcemanager

clus10:8088

clus11:8088

5.配置文件在spark客户端上添加一个配置文件

cp spark-defaults.conf.template spark-defaults.conf

vim spark-defaults.conf

文件内容修改如下

#作用:bin/spark-submit 后面跟了一大堆参数;这些参数如果放到了这个文件中;每次运行spark-submit的时候,会自动的从这个文件找参数;

#这个文件只需要放到运行bin/spark-submit的服务器上就可以(建议四台机器一块放)

#空格左边的叫键,右边叫值; 它会在bin/spark-submit后面的参数前面 加上spark;

# spark standlone 的大哥

spark.master spark://clus11:7077

# executor 的内存; 如果这里面要是木有,就还加上bin/spark-submit的参数上

spark.executor.memory 500m

#启用历史服务器

spark.eventLog.enabled true

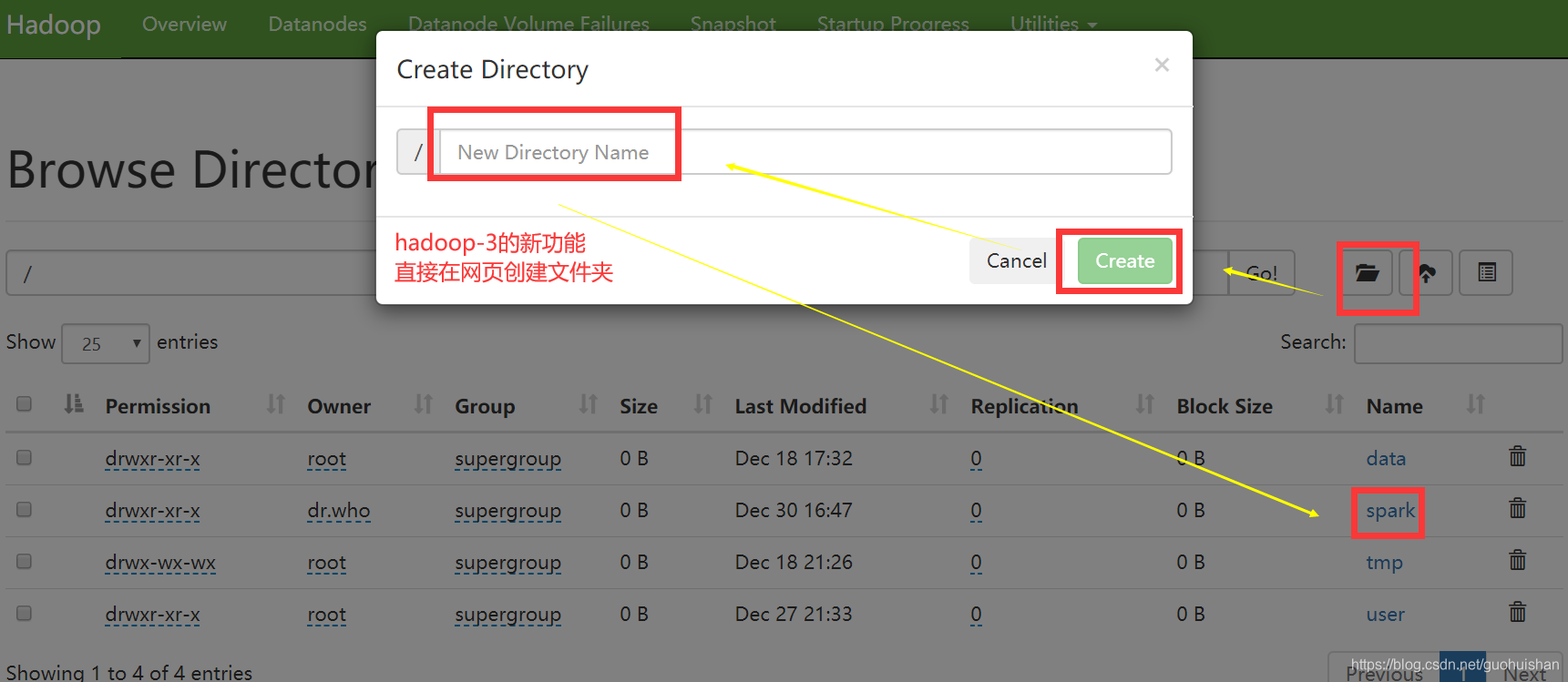

#历史服务器会写一些日志,这个目录是日志的存储目录(如果目录不存在,得创建)这个clus10节点是#namenode为active的节点

spark.eventLog.dir hdfs://clus10:8020/spark/logs

#读取目录

spark.history.fs.logDirectory hdfs://clus10:8020/spark/logs

完成配置之后

在master上开启spark(clus11)

sbin/start-all.sh

在客户端开启历史服务器(clus10)

sbin/start-history-server.sh

在客户端提交运算圆周率

bin/spark-submit \

--name myPi \

--total-executor-cores 2 \

--class org.apache.spark.examples.SparkPi \

examples/jars/spark-examples_2.11-2.4.4.jar \

100

网页查看

clus10::18080

clus10:18080

来源:CSDN

作者:郭惠姗

链接:https://blog.csdn.net/guohuishan/article/details/103771924