0.jdk,jvm,jre

jdk包括jre,jre=jvm+lib(类库)。运行Java时:去它的环境变量的path里面所列出的路径里面找到jre,然后运行java。因此安装了jdk后,要更改path,告诉电脑jre在这儿。

1.ssh

认证:

①基于口令的认证

只要知道对方的账号和口令就OK

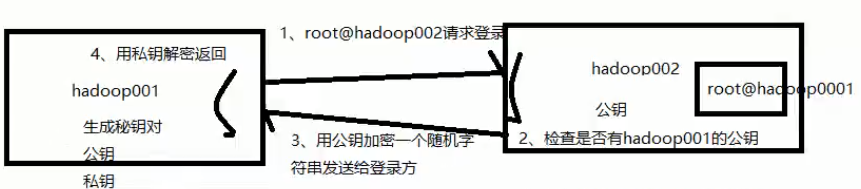

②基于密钥的安全认证

说明:主机A首先(登录方)生成密钥对,包括公钥和私钥,并把公钥发给主机B。

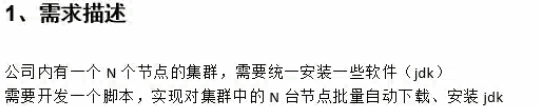

2.小需求

注意:文件服务器上建立启动脚本(启动任务)和安装脚本(负责下载安装包并安装配置),启动脚本将安装脚本下发到各个节点中,然后各个节点执行安装脚本(服务器利用ssh命令一登录过去之后,执行安装脚本)

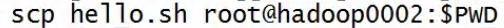

scp:

将hello.sh放到另一台机器(hadoop0002上的当前目录下),以root登录。

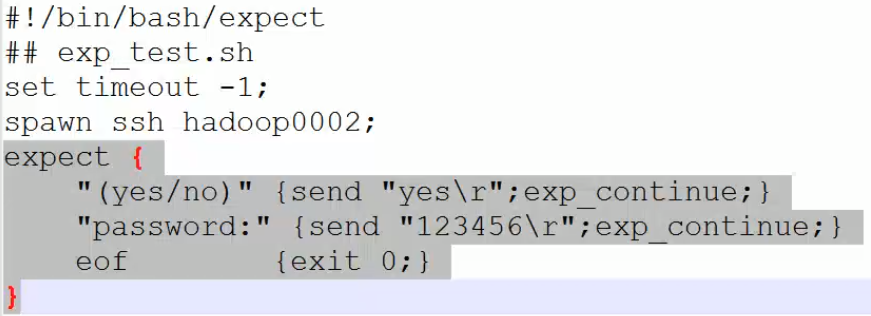

用expect来自动登录到另一台机器上:

先安装expect:

yum lis | grep expect

yum -y install expect.x86_64

再vi a.sh:

说明:timeout超时设置为-1表示不等待了,执行完上一条直接到下一条了。如果设置为10,表示等待10s,10s之后认为是超时,则执行下一条命令。spawn监控。expect里面第一行,如果监控到有yes/no的字样,则进行后面的动作,发送yes\r,并继续监控。第二次如果有password。如果没了,就退出。

再expect -f(文件) a.sh

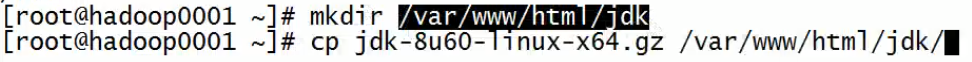

内网放jdk:

在web主目录新建目录,并把jdk包放入:

最终解决:

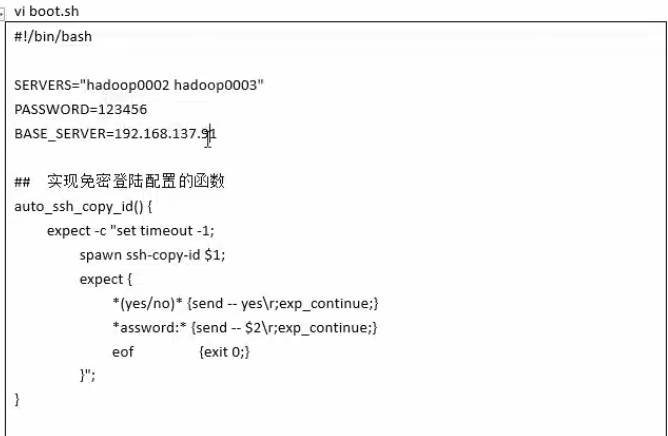

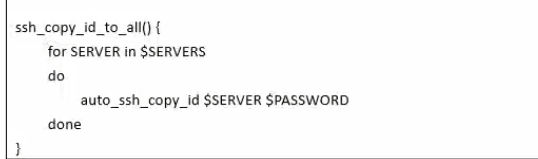

说明:BASE_SERVERE是node01的IP,上面的函数是针对单个主机,下面的函数调用上面的函数对所有主机(node02,node03)进行

说明:大致步骤:首先实现免密登录(后期登录不用输入密码和不再显示提示),再对第一个对象:先拷贝install.sh脚本,再登过去执行,再对第二个对象。。。。

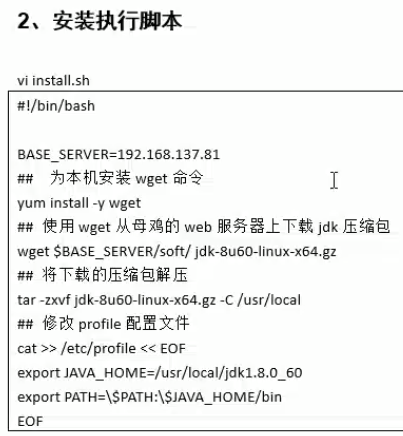

说明:BASE_SEVERE是node01的ip,wget从node01上搭建的web服务器上下载jdk。最后在/etc/profile中追加两行变量的设置。

接着:

chmod u+x install.h

sh boot.sh:不加权限,用sh直接执行boot.sh

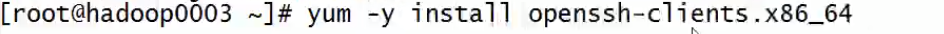

注意:ssh客户端有scp。如果小鸡上没有安装scp,说明它也没有安装ssh客户端,需要给它安装上

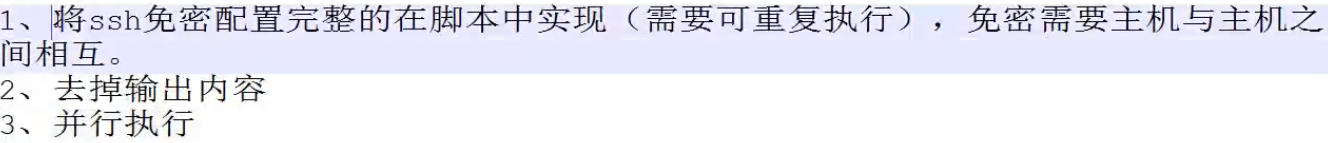

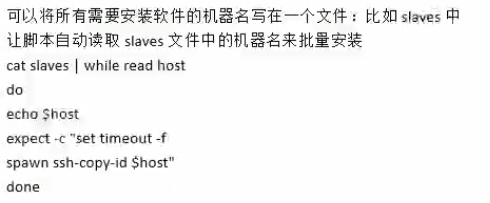

改进:

④、目标机器名要写死在脚本中

说明:

①.可将免密配置放到install里面;

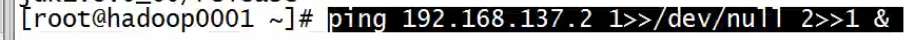

②.重定向

其中1表示标准输出,2表示错误输出

④.

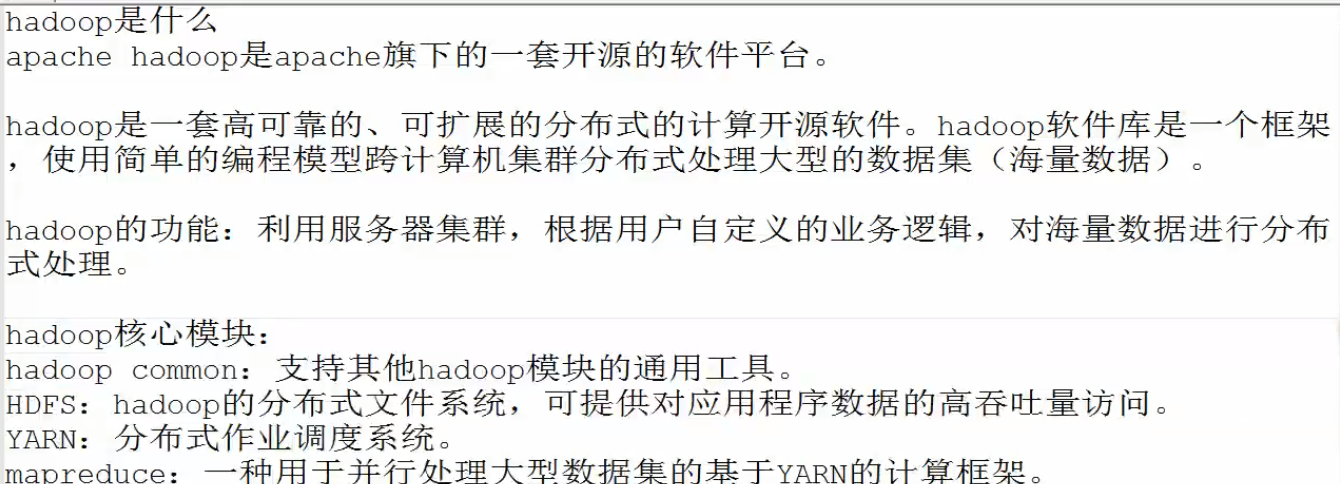

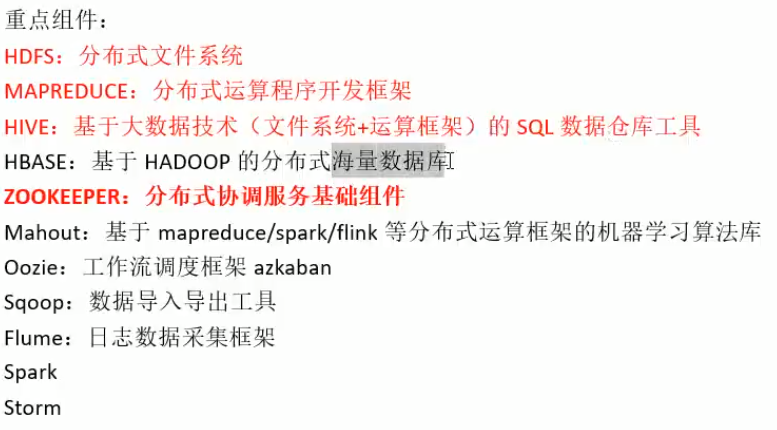

3.hadoop简介

说明:hadoop是一个平台,上面放东西。hadoop软件库是一个框架,不包含业务,里面可以放各种软件,业务。HDFS是存文件的。YARN是分配作业的。

4.hadoop安装

前2种是安装在单节点上,第三种安装在多个结点上

第一种模式安装:

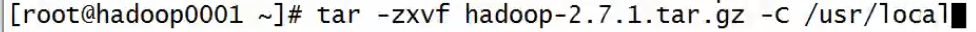

①传入hadoop压缩包并解压

进入/usr/local修改小错误:

②编辑配置文件

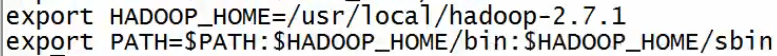

vi /etc/profile

追加:

说明:sbin是针对系统管理员的

source /etc/profile

③查看安装

hadoop version

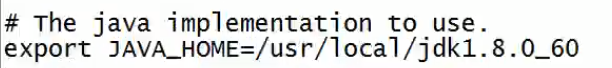

④更改hadoop的运行环境

vi /usr/local/hadoop2.7.1/etc/hadoop/hadoop_env.sh

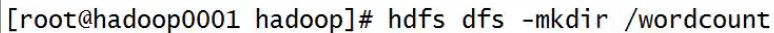

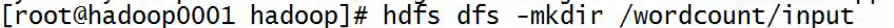

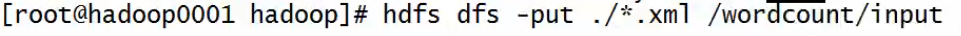

⑤实现案例,创建个自己的目录,再创建个input目录存放输入的数据

⑥用put上传数据到目录,现在在自己本机上可以用cp的

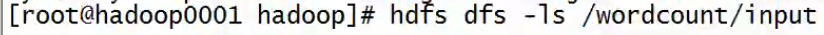

⑦查看一下

来源:https://www.cnblogs.com/pjishu/p/12151074.html