历史以来,提升准确率方法 增加深度,增大宽度,使用更小的stride, 新的非线性激活函数、巧妙的结构设计、更好的归一化技巧、数据增广、大数据规模

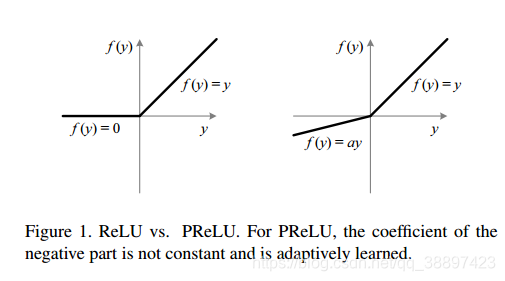

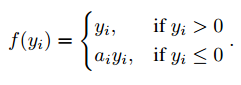

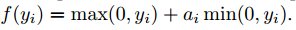

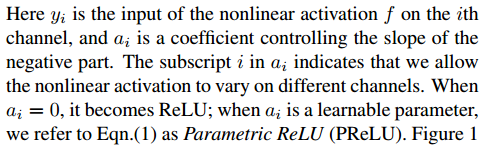

在这里,ai表示第i个神经元的系数,不同神经元 PRelu系数不一样

当ai固定为一个较小数(ai=0.01)时,为Leaky ReLu

在文章中,作者使ai=0.5初始化

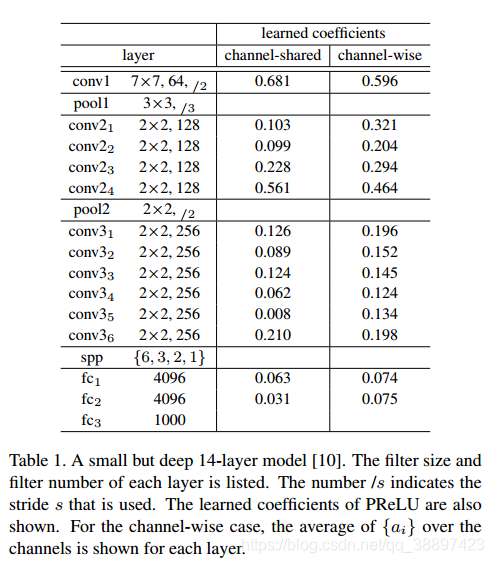

称每层共享ai的层位 channel-shared,不共享为channel-wise

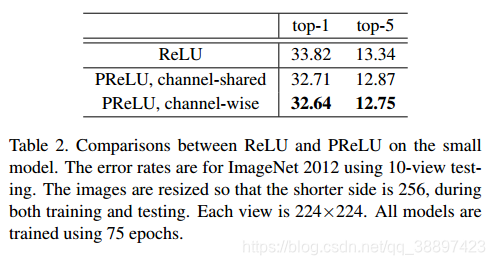

channel-shared、channel-wised、Relu对比实验

1、channel-wise>channel-shared>ReLu

2、发现随着在deeper layer中,ai系数越小,即非线性程度越高、说明在表层提取保留更多信息而在深层更discriminative(具有辨识力)

网络初始化:

1、以往网络参数初始化 服从高斯分布的随机初始化,有固定方差

2、VGG中使用 先训练浅层网络、再利用预训练浅层网络参数训练深层网络

3、加辅助分类器在中间层帮助收敛

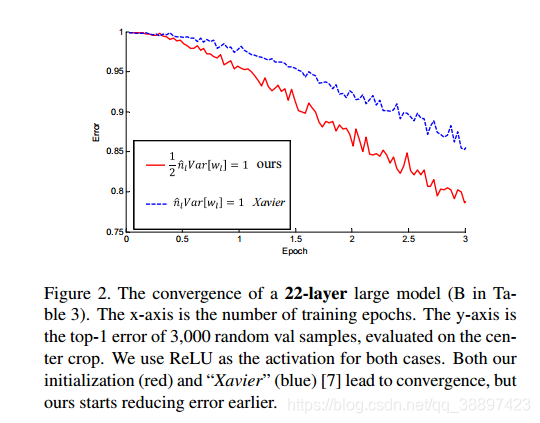

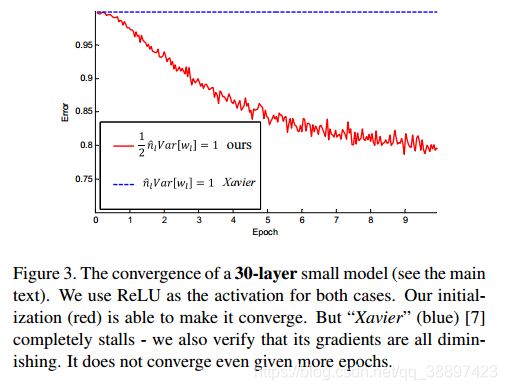

二、论文中提出新的网络初始化方法

使得在更深的网络中也不至于diminishing,变得trainable,同时收敛更快

提出空间金字塔池化 spatial pyramid pooling

来源:CSDN

作者:qq_38897423

链接:https://blog.csdn.net/qq_38897423/article/details/103475887