【论文笔记】Watch Your Step

论文名称:Watch Your Step: Learning Graph Embeddings Through Attention

这篇文章的出发点是自动化选择网络表示学习的参数从而适应不同网络的需求。同时文章也证明了DeepWalk的工作其实等同于矩阵分解。

Introduction

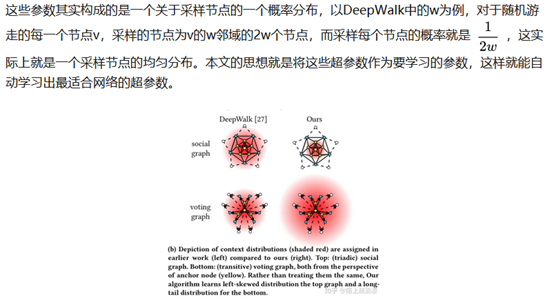

文章分析了之前一些工作的一个不可避免的问题,那就是模型参数的选择问题。对于不同的网络,模型能达到最好效果的参数是不同的,如果对于每个新出现的问题都要反复试验找到合适的参数,这显然是低效的。这些参数包括DeepWalk中窗口大小w的选取,node2vec中定义的两个跟随机游走有关的参数p、q。参数的选取完全影响着模型的好坏。

具体要做的有以下几点:

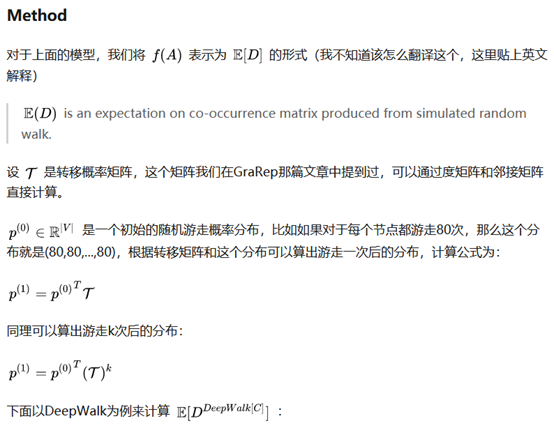

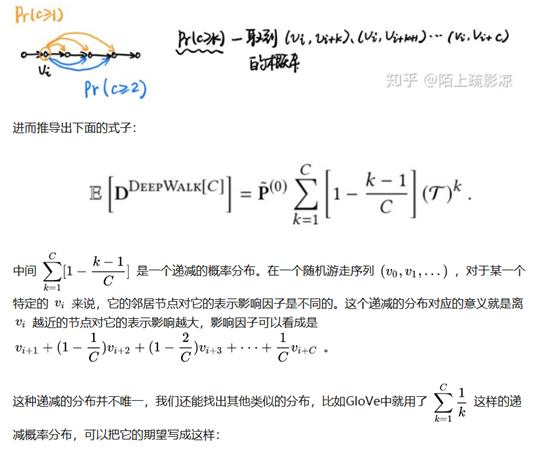

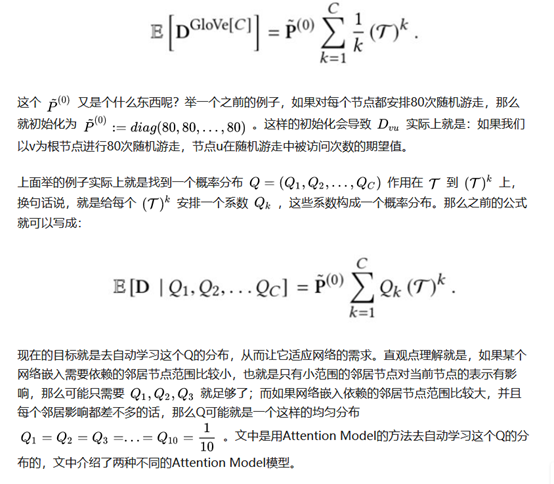

- 把随机游走中对节点的上下文采样过程看成是对转移概率矩阵的期望。

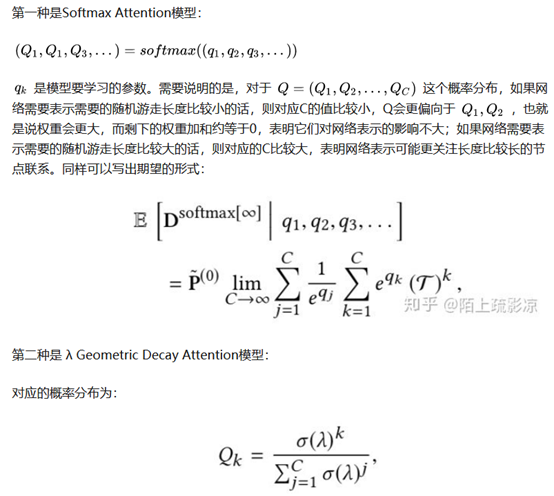

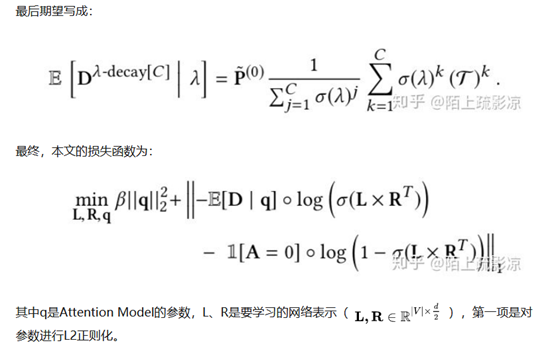

- 通过证明DeepWalk等同于矩阵分解发现上述的采样过程对应的目标是k阶转移概率矩阵。在这个不同的k阶转移矩阵前的系数就定义了一种对节点不同的采样过程。引入Attention Model自动学习这些系数,从而达到最好的采样效果。

- 用Attention Model学习出来的参数和人工调出来的参数效果差不多,进一步证明了方法的可行性。

Related Works

相关工作中提到了两种图学习算法:

一种是为网络的每个节点或每条边预测一个label。

The first class is concerned with predicting labels over a graph, its edges, and/or its nodes. Typically, these algorithms process a graph (nodes and edges) as well as per-node features.

一种是网络嵌入的方法。

The second class of algorithms consist of graph embedding meth- ods. Their primary goal is to preserve the graph structure. They explicitly model the relationship of all node pairs e.g. as dot product of node embeddings.

Preliminaries

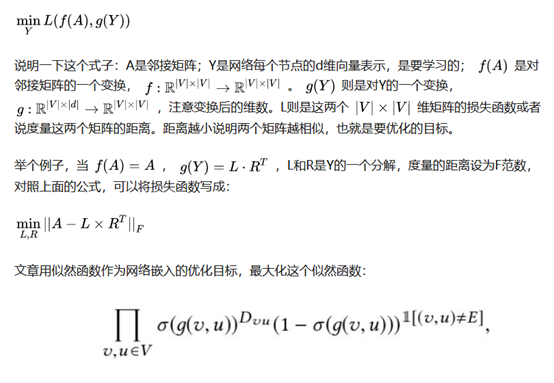

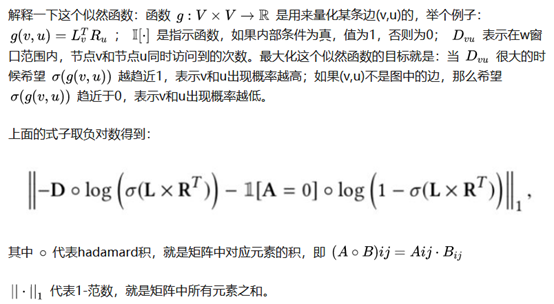

首先定义了网络嵌入,这篇文章的定义与之前的不太一样,它将网络嵌入的优化目标定义为:

来源:https://www.cnblogs.com/kexinxin/p/12013354.html