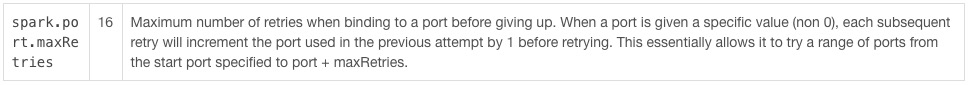

spark的yarn-cluster模式

1. 程序提交作业到ResourceManager,请求启动ApplicationMaster

2. ResourceManager会分配container,在某个NodeManager上面启动ApplicationMaster,相当于Driver

3. ApplicationMaster启动后,会和ResourceMananger通讯,请求container来启动executor

4. ResourceManager会提供一些container给ApplicationMaster用来启动executor

5. ApplicationMaster会连接其他NodeManager来启动executor

6. executor启动后会向ApplicationMaster反向注册

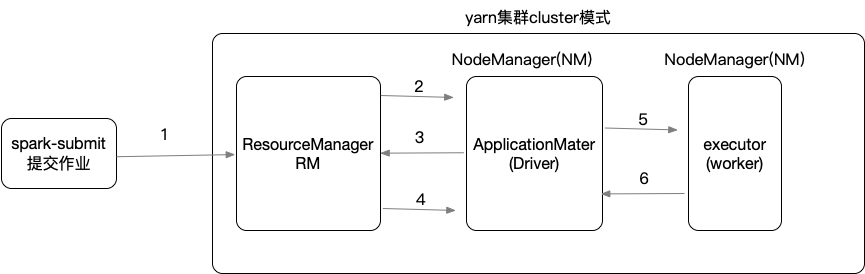

spark的yarn-client模式

1. yarn-client,区别在于driver是在本地客户端上运行的,相应的ApplicationMaster只是作为一个Executor启动器,并没有相应的Driver进程

| yarn-cluster | yarn-client |

| driver运行在AM中 | driver运行在client客户端 |

| 日志分布在各个节点上,需要登录到某个节点才能看到日志 | 比较适合于调试,日志存在客户端,可以直接查看到各种日志 |

| client断开的话,任务不受影响,可以继续运行 | 连接断了,任务就会被中断 |

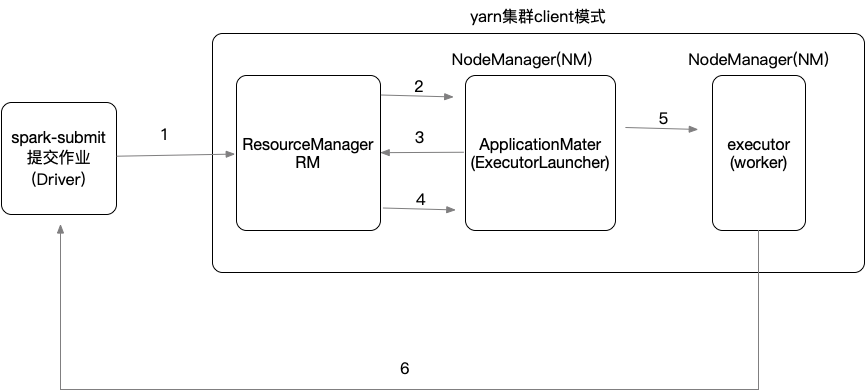

注意:spark任务都会绑定一个端口来显示WebUI,默认端口是4040,如果端口被占用会依次递增+1端口重试,重试次数由参数spark.port.maxRetries=16控制,默认重试16次后放弃执行