决策树学习的目的是为了产生一棵泛化能力强的决策树,其基本流程遵循简单且直观的分而治之的策略

1 决策树递归返回的三个条件:

(1)当前节点包含的样本属于同一类别;

(2)当前属性集为空,或者所有样本在所有属性值上取值相同,无法划分

(3)当前节点包含的样本集合为空,不能划分

2 划分选择

决策树学习的关键是如何选择最优的划分属性,划分的选择有信息增益,信息增益率和基尼指数,分别对应ID3,C4.5和CART算法。

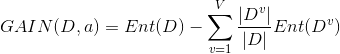

假设样本集合D,离散特征a有v个可能的取值,若用a进行划分,则可以产生v 个节点,其中第v个结点包含了所有在a上取值为a^v的样本D^v

2.1 信息增益

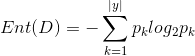

信息熵

信息增益

一般而言,信息增益越大,则意味着使用属性a来进行划分所获得的纯度提升越大,因此信息增益可以用来进行决策树的划分属性选择。

缺点:信息增益偏向取值类别多的属性

2.2 信息增益率