Generation

可以用RNN生成文本、图片(grid lstm)、视频、手写字、语音

*grid lstm

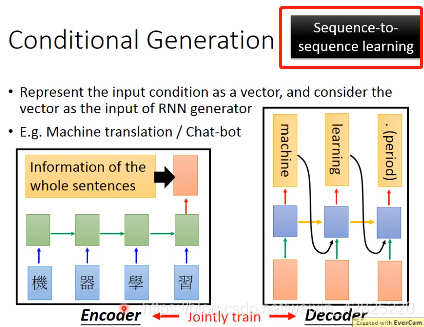

Conditional generation:不是随机产生,而是有情境地产生

应用:image caption/machine translation/chat-bot

Encoder和Decoder的参数可以一样或者不一样,当参数一样时,参数比较少,比较不容易过拟合,但是如果有足够的数据,那么也可以参数不一样

这也就是seq2seq

双层encoder记录过去历史

Attention:是一种动态的conditional generation

每个时间点关注不同的信息,可以不用将所有信息都放在一个vector中

Match函数可以自己设计

z1

是c0

是c0 输入到RNN后hidden layer的输出

输入到RNN后hidden layer的输出 attention还可以应用于语音识别,但效果不如传统的HMM方法

attention应用于image caption,将attention应用于flatten前的一组vector上

Memory Network

在memory上做attention

传统memory network中attention和抽取信息是对同一组vector

升级版:将attention和抽取信息分开,将同一个句子变成两组不同的vector,分别进行

Hopping:将抽取的信息传给q可以使得机器反复思考,得到更好的效果

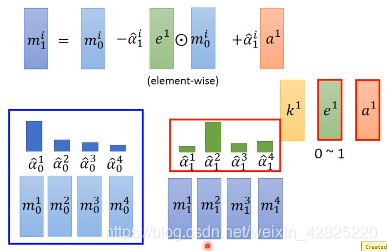

Neural Turing Machine

根据match score修改存在memory中的内容

其中由

这三个vector决定attention和修改memory

这三个vector决定attention和修改memory k1

决定attention,e1

决定attention,e1 清空memory的值,a1

清空memory的值,a1 写memory的值

写memory的值

文章来源: https://blog.csdn.net/weixin_42825220/article/details/97297713